docker核心技术 - python爬虫高薪系列课程

替代产品: containerd, vagrant

l

- 从 Docker 1.10 开始,

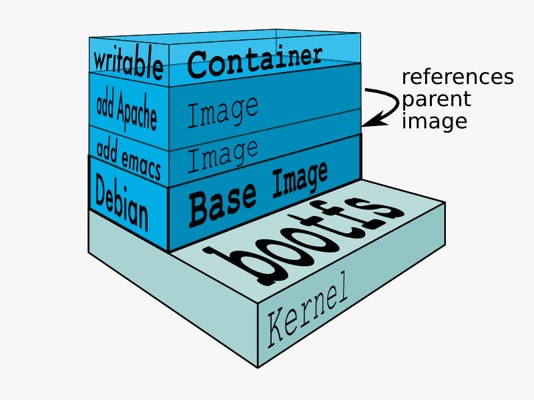

COPY、ADD和RUN语句会向镜像中添加新层。前面的示例创建了两个层而不是一个。 - Docker提供了一种非常便利的打包机制. 这种机制直接导包了应用运行所需要的整个操作系统, 从而保证了本地环境和云端环境的高度一致性, 避免了用户通过"试错"来匹配两种不同运行环境之间差异的痛苦过程.

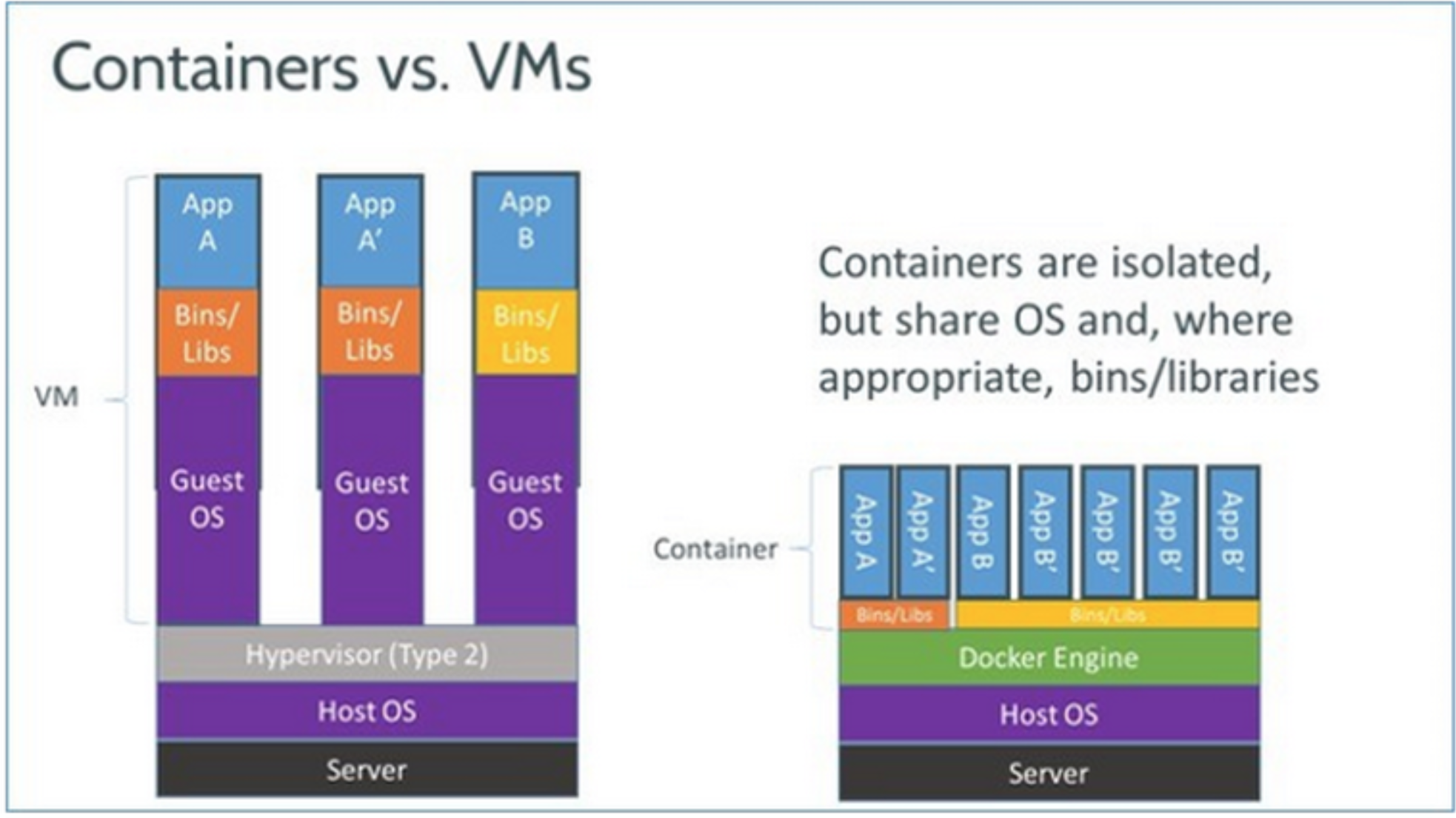

相比于传统虚拟化技术

更高效的利用系统资源 由于容器不需要进行硬件虚拟以及运行完整操作系统等额外开销,Docker 对系统资源的利用率更高。无论是应用执行速度、内存损耗或者文件存储速度,都要比传统虚拟机技术更高效。因此,相比虚拟机技术,一个相同配置的主机,往往可以运行更多数量的应用。

更快速的启动时间 传统的虚拟机技术启动应用服务往往需要数分钟,而 Docker 容器应用,由于直接运行于宿主内核,无需启动完整的操作系统,因此可以做到秒级、甚至毫秒级的启动时间。大大的节约了开发、测试、部署的时间。

一致的运行环境 开发过程中一个常见的问题是环境一致性问题。由于开发环境、测试环境、生产环境不一致,导致有些 bug 并未在开发过程中被发现。而 Docker 的镜像提供了除内核外完整的运行时环境,确保了应用运行环境一致性,从而不会再出现 「这段代码在我机器上没问题啊」 这类问题。

持续交付和部署 对开发和运维(DevOps)人员来说,最希望的就是一次创建或配置,可以在任意地方正常运行。 使用 Docker 可以通过定制应用镜像来实现持续集成、持续交付、部署。开发人员可以通过 Dockerfile 来进行镜像构建,并结合 持续集成( Continuous Integration) 系统进行集成测试,而运维人员则可以直接在生产环境中快速部署该镜像,甚至结合 持续部署(Continuous Delivery/Deployment) 系统进行自动部署。 而且使用 Dockerfile 使镜像构建透明化,不仅仅开发团队可以理解应用运行环境,也方便运维团队理解应用运行所需条件,帮助更好的生产环境中部署该镜像。

更轻松的迁移 由于 Docker 确保了执行环境的一致性,使得应用的迁移更加容易。Docker 可以在很多平台上运行,无论是物理机、虚拟机、公有云、私有云,甚至是笔记本,其运行结果是一致的。因此用户可以很轻易的将在一个平台上运行的应用,迁移到另一个平台上,而不用担心运行环境的变化导致应用无法正常运行的情况

更轻松的维护和扩展

Docker 使用的分层存储以及镜像的技术,使得应用重复部分的复用更为容易,也使得应用的维护更新更加简单,基于基础镜像进一步扩展镜像也变得非常简单。此外,Docker 团队同各个开源项目团队一起维护了一大批高质量的 官方镜像,既可以直接在生产环境使用,又可以作为基础进一步定制,大大的降低了应用服务的镜像制作成本。

- 所有的官方镜像都有

Dockerfile,以及在github上有全部生成镜像的配套文件,遵循了Dockerfile的最佳实践,这些也是很好地学习资料。

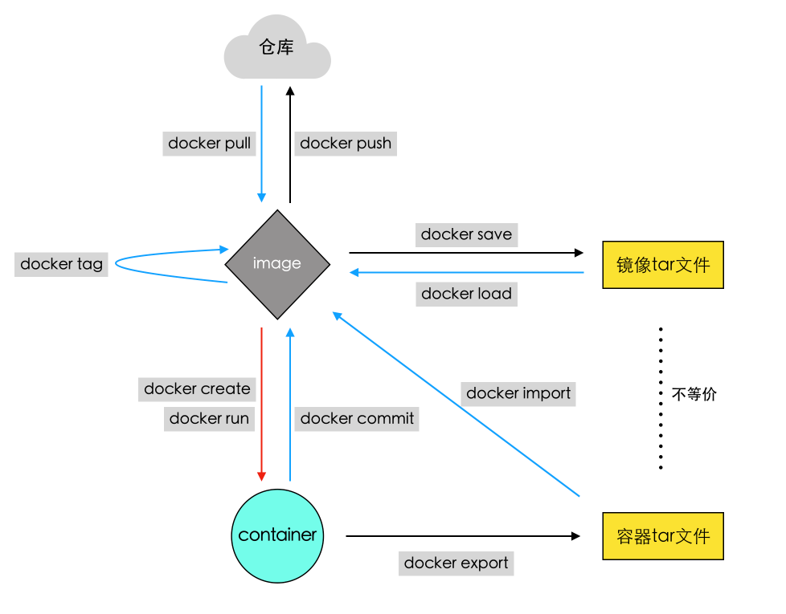

dockerfile -> image -> container -> repository

制作 -> 镜像 -> 容器 -> 仓库

- 了解 Docker 与虚拟机的不同点,相比的优势

- 掌握 Docker 的启动方法

- 掌握 Docker 镜像操作

- 掌握 Docker 容器操作

- Docker整体架构, 底层技术

容器中的数据应该尽量保存到宿主机上

docker 三大部分 《docker实战》

推荐直接按照官方Guide操作

- https://docs.docker.com/engine/install/ubuntu/

- https://docs.docker.com/desktop/install/mac-install/

- https://docs.docker.com/desktop/install/linux-install/

# 通过镜像安装

curl -fsSL https://get.docker.com | bash -s docker --mirror Aliyun```shell

# 官网安装

sudo apt-get update

# 安装包允许apt通过HTTPS使用仓库

sudo apt-get install \

apt-transport-https \

ca-certificates \

curl \

software-properties-common

# 添加Docker官方GPG key

# 设置Docker稳定版仓库

sudo add-apt-repository \

"deb [arch=amd64] https://download.docker.com/linux/ubuntu \

$(lsb_release -cs) \

stable"

# 更新apt索引源

sudo apt-get update

# 安装最新版Docker CE(社区版)

sudo apt-get install docker-ce

# 检查Docker CE是否安装成功

docker run hello-world

# 设置用户权限, 以避免每次命令都输入sudo

# https://docs.docker.com/engine/install/linux-postinstall/

# 执行命令后须注销重新登录

sudo usermod -a -G docker $USER

# 这样就安装完毕了!

# https://get.docker.com/

https://developer.aliyun.com/mirror/docker-ce/

curl -fsSL https://get.docker.com | bash -s docker --mirror Aliyun

systemctl enable --now docker

### 镜像加速

# 参考资料

# https://gist.github.com/y0ngb1n/7e8f16af3242c7815e7ca2f0833d3ea6

# 阿里云

"registry-mirrors": ["https://qdyoqqzy.mirror.aliyuncs.com"],

# 清华

{

"registry-mirrors": ["https://docker.mirrors.tuna.tsinghua.edu.cn"]

}

# 腾讯云

https://mirror.ccs.tencentyun.com

# 科大镜像源

https://docker.mirrors.ustc.edu.cn

{

"registry-mirrors": ["https://docker.mirrors.ustc.edu.cn"]

}

# Docker镜像代理

https://dockerproxy.com

# 服务管理

sudo systemctl start|stop|restart|status docker

# 查看容器的运行状态

sudo systemctl emable docker### 镜像相关

# 列出镜像

docker image ls

docker images

# 从官方拉取镜像

docker image pull library/hello-world

docker image pull hello-world

# 拉取镜像

docker pull ubuntu

docker pull ubuntu:latest

docker pull ubuntu:rolling

docker pull mongo:3.2.4

# 搜索/查找镜像

docker search mysql

# 从本地将镜像加载到本地镜像库

docker load -i ./ubuntu.tar

# 删除镜像

docker image rm 镜像名或镜像ID

docker image rm hello-world

容器命令的用法等同于ubuntu / linux , 容器就是一个ubuntu的环境

一个镜像可以同时创建多个容器, 彼此独立(需要以不同名称来表示)

### 容器相关命令

# 创建容器

docker run [option] 镜像名 [向启动容器中传入的命令]

# 交互式容器

docker run -it --name=myubuntu ubuntu /bin/bash

# 守护式容器: 长期运行容器

docker run -dit --name=myubuntu2 ubuntu

# 进入已运行的容器

docker exec -it 容器名或容器id 进入后执行的第一个命令

docker exec -it myubuntu2 /bin/bash

# 查看容器: 正在运行 / 所有容器

# 列出本机正在运行的容器

docker container ls

# 列出本机所有容器, 包括已经终止运行的

docker container ls --all

# 停止与启动容器

# 停止一个已经在运行的容器

docker container stop 容器名或容器id

# 启动一个已经停止的容器

docker container start 容器名或容器id

# 强行杀掉(停止)容器

docker container kill 容器名或容器id

# 删除容器

docker container rm 容器名或容器id

# 将容器保存为镜像

docker commit 容器名 镜像名

# 镜像备份与迁移

# 备份==打包, 并保存到本地

docker save -o 保存的文件名 镜像名

docker save -o ./ubuntu.tar ubuntu

# 将镜像加载到本地

docker load -i ./ubuntu.tar

| Usage: | docker [OPTIONS] COMMAND |

|---|---|

| A self-sufficient runtime for containers | |

| Options: | |

| --config string | Location of client config files (default "/home/wwfyde/.docker") |

| -c, --context string | Name of the context to use to connect to the daemon (overrides DOCKER_HOST env var and default context set with "docker context use") |

| -D, --debug | Enable debug mode |

| -H, --host list | Daemon socket(s) to connect to |

| -l, --log-level string | Set the logging level ("debug"|"info"|"warn"|"error"|"fatal") (default "info") |

| --tls | Use TLS; implied by --tlsverify |

| --tlscacert string | Trust certs signed only by this CA (default "/home/wwfyde/.docker/ca.pem") |

| --tlscert string | Path to TLS certificate file (default "/home/wwfyde/.docker/cert.pem") |

| --tlskey string | Path to TLS key file (default "/home/wwfyde/.docker/key.pem") |

| --tlsverify | Use TLS and verify the remote |

| -v, --version | Print version information and quit |

| Management Commands: | |

| builder | Manage builds |

| config | Manage Docker configs |

| container | Manage containers |

| context | Manage contexts |

| engine | Manage the docker engine |

| image | Manage images |

| network | Manage networks |

| node | Manage Swarm nodes |

| plugin | Manage plugins |

| secret | Manage Docker secrets |

| service | Manage services |

| stack | Manage Docker stacks |

| swarm | Manage Swarm |

| system | Manage Docker |

| trust | Manage trust on Docker images |

| volume | Manage volumes |

| Commands: | |

| attach | Attach local standard input, output, and error streams to a running container |

| build | Build an image from a Dockerfile |

| commit | Create a new image from a container's changes |

| cp | Copy files/folders between a container and the local filesystem |

| create | Create a new container |

| diff | Inspect changes to files or directories on a container's filesystem |

| events | Get real time events from the server |

| exec | Run a command in a running container |

| export | Export a container's filesystem as a tar archive |

| history | Show the history of an image |

| images | List images |

| import | Import the contents from a tarball to create a filesystem image |

| info | Display system-wide information |

| inspect | Return low-level information on Docker objects |

| kill | Kill one or more running containers |

| load | Load an image from a tar archive or STDIN |

| login | Log in to a Docker registry |

| logout | Log out from a Docker registry |

| logs | Fetch the logs of a container |

| pause | Pause all processes within one or more containers |

| port | List port mappings or a specific mapping for the container |

| ps | List containers |

| pull | Pull an image or a repository from a registry |

| push | Push an image or a repository to a registry |

| rename | Rename a container |

| restart | Restart one or more containers |

| rm | Remove one or more containers |

| rmi | Remove one or more images |

| run | Run a command in a new container |

| save | Save one or more images to a tar archive (streamed to STDOUT by default) |

| search | Search the Docker Hub for images |

| start | Start one or more stopped containers |

| stats | Display a live stream of container(s) resource usage statistics |

| stop | Stop one or more running containers |

| tag | Create a tag TARGET_IMAGE that refers to SOURCE_IMAGE |

| top | Display the running processes of a container |

| unpause | Unpause all processes within one or more containers |

| update | Update configuration of one or more containers |

| version | Show the Docker version information |

| wait | Block until one or more containers stop, then print their exit codes |

广义值Docker管理平台, 狭义值一个容器

任何应用的运行都会依赖于一些相应的环境

Docker是开发, 运行和部署应用程序的开放管理平台

- 开发人员利用Docker开发和运行应用程序

- 运维人员利用Docker部署和管理应用程序

Docker平台介绍(The Docker Platform)

Docker提供了在一个完全隔离的环境中打包和运行程序的能力, 这个隔离的环境被称为容器.

由于容器的隔离性和安全性, 因此可以在一个主机(宿主机)上同时运行多个相互隔离的容器, 互不干预

Docker容器已经提供工具和组件(Docker Client, Docker Daemon)来管理容器的生命周期:

- 使用容器来开发应用程序及其支持组件

- 容器成为分发和测试你的应用程序的单元

- 准备好后, 将您的应用部署到生产环境中, 作为容器或协调程序. 无论您的生产环境是本地数据中心, 云提供商还是两者的混合, 这都是一样的

- Docker方便开发者将应用程序与基础架构分开, 以便快速交付软件

- 借助Docker, 开发者可以像管理应用程序一样管理基础架构

- 通过利用Docker的方法快速进行运输, 测试和部署代码, 开发者可以显著缩短编写代码和在生产环境中运行代码之间的延迟

- 开发人员在本地编写代码, 可以使用Docker与同事进行共享, 实现协同工作.

- 使用Docker开发完程序, 可以直接对应用程序执行自动和手动测试

- 当开发人员发现错误或BUG时, 可以直接在开发环境中修复后, 并迅速将她们重新部署到测试环境进行测试和验证

- 利用Docker开发完成后, 交付时, 直接交付Docker, 也就意味着交付完成. 后续如果有提供修补程序或更新, 需要推送到生成环境运行起来, 也是一样简单.

- 保证程序运行环境的一致性

- 降低配置开发环境和生产环境的复杂度及成本

- 实现应用程序的快速部署和分发

Docker可以被理解为一个程序, 可以直接安装到操作系统中, 像应用程序一样来操作它. Docker主要负责管理容器(Container)

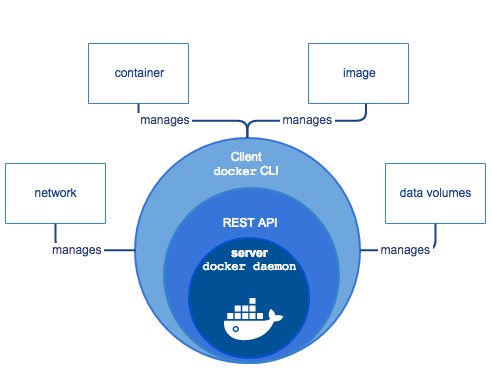

Docker Engine是一个包含以下组件的客户端-服务端(C/S)应用程序

- 服务端 -- 一个长时间运行的守护进程(Docker Daemon)

- REST API -- 一套用于与Docker Daemon通信并指示其执行操作的接口

- 客户端 -- 命令行接口CLI(Command Line Interface)

- CLI利用Docker命令通过REST API直接操控Docker Daemon执行操作

- Docker Daemon负责创建并管理Docker的对象(镜像, 容器, 网络, 数据卷)(image, container, network, data volumes)

DOcker Client是用户与Docker进行交互的最主要方式. 当在终端输入docker命令时, 对应的就会在服务端产生对应的作用, 并把结果返回给客户端. Docker Client处理连接本地服务端,还可以通过更改或指定DOCKER_HOST连接远程服务端

Docker Daemon其实就是Docker的服务端. 它负责监听Docker API请求(如Docker Client)并管理Docker对象(Docker Objects), 如image, container, network, volume.

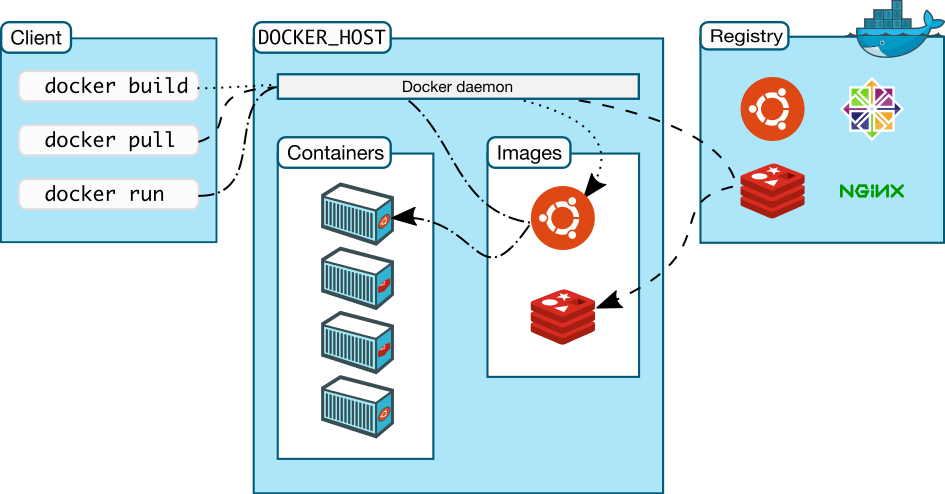

俗称DOcker仓库, 专门用于存储镜像的云服务环境

Docker Hub就是一个公有的存放镜像的地方, 类似Github存储代码文件. 同样的也可以类似Github那样搭建私有的仓库.

- 镜像:一个Docker的可执行文件, 其中包括运行程序所需的所有代码内容, 依赖库, 环境变量和配置文件等.

- 容器: 镜像被运行起来后的实例.

- 网络: 外部或者容器间如何相互访问的网络方式, 如host, bridge.

- 数据卷: 容器与宿主机之间, 容器与容器之间共享存储方式, 类似须立即与主机之间的共享文件目录.

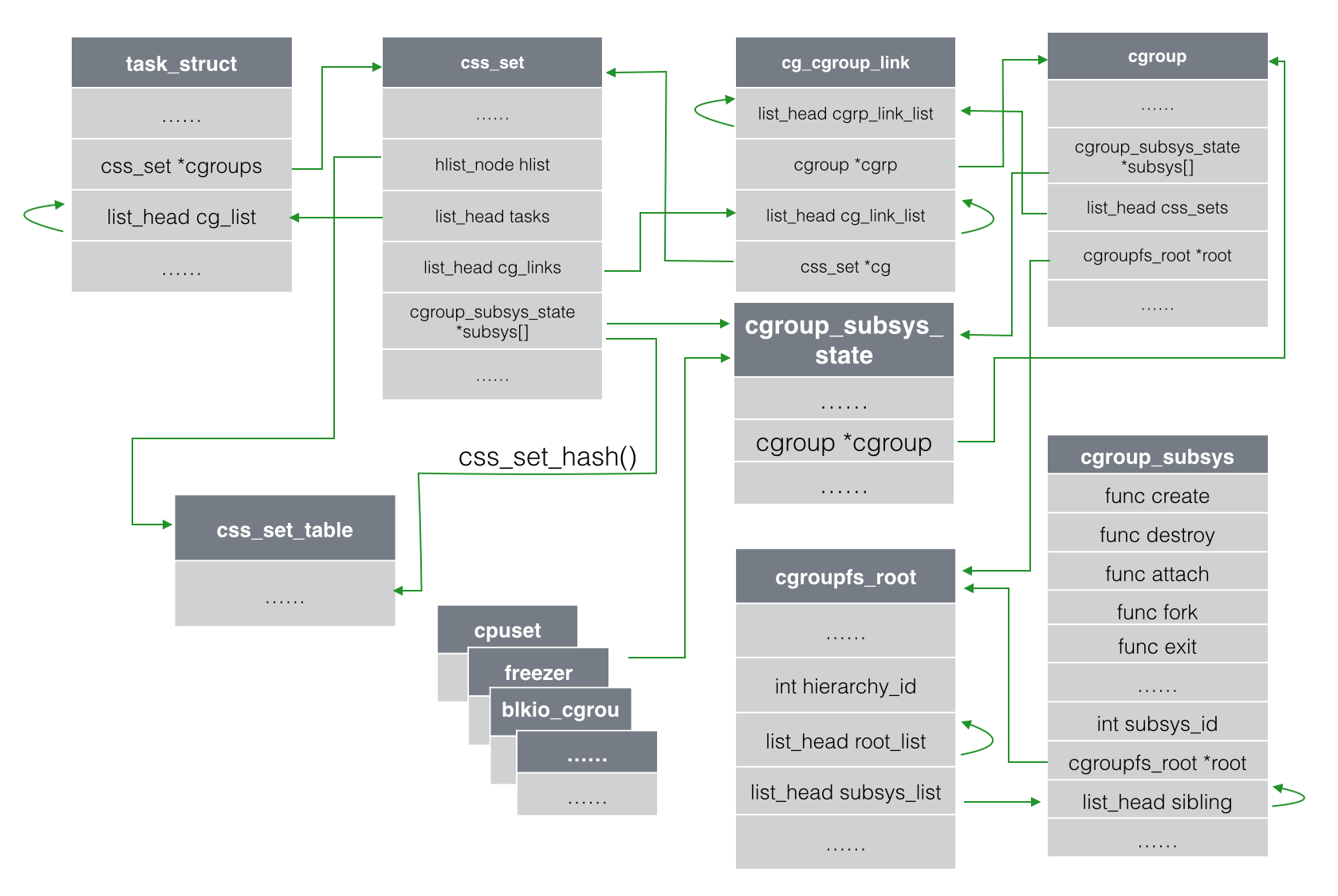

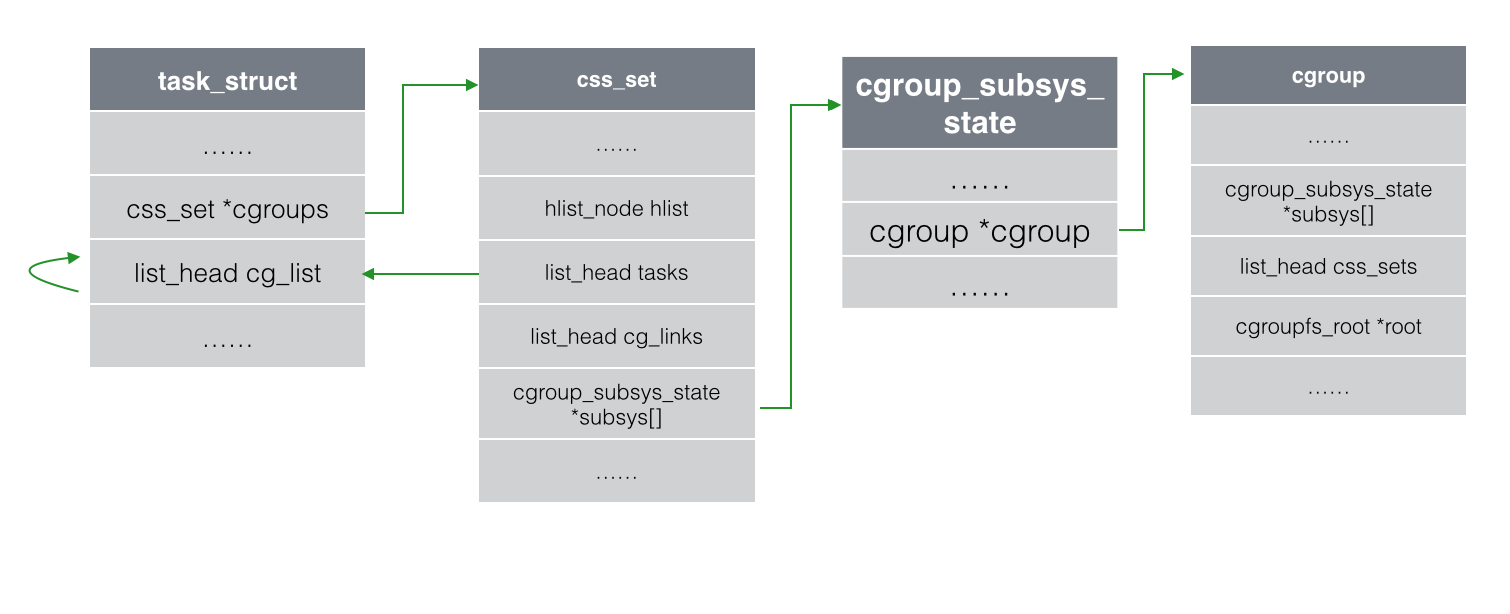

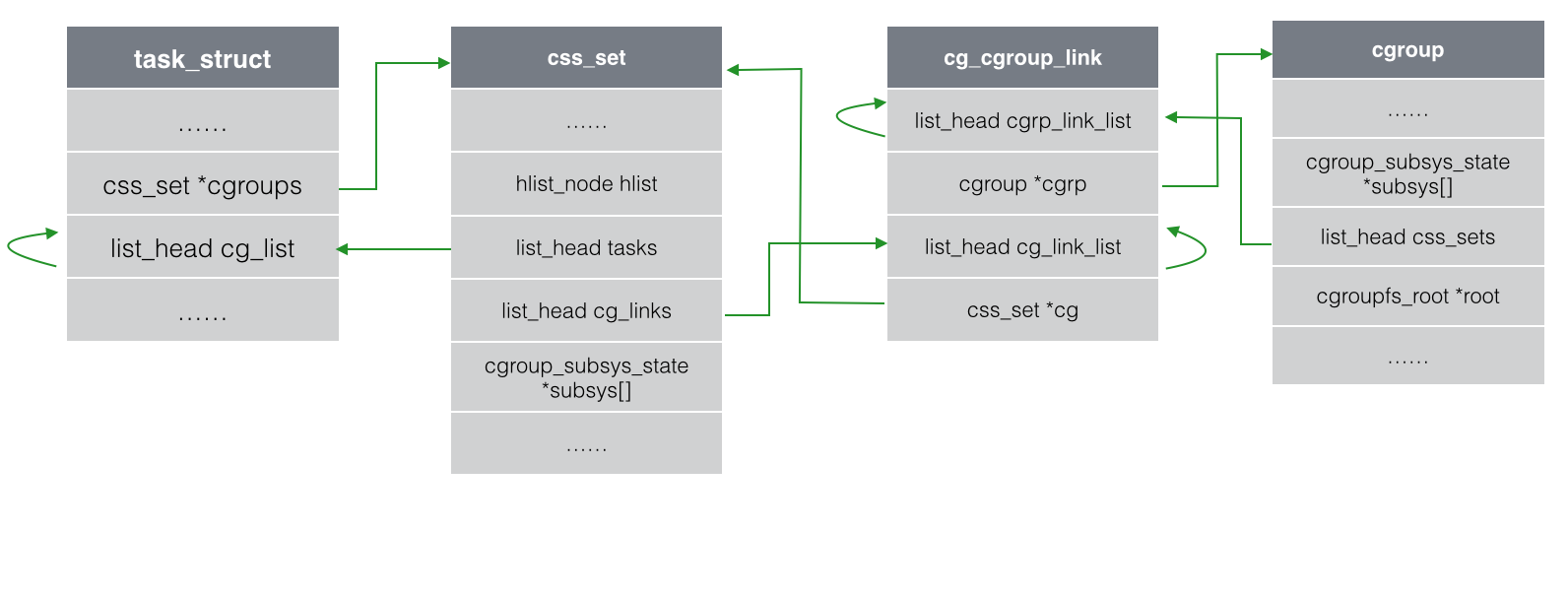

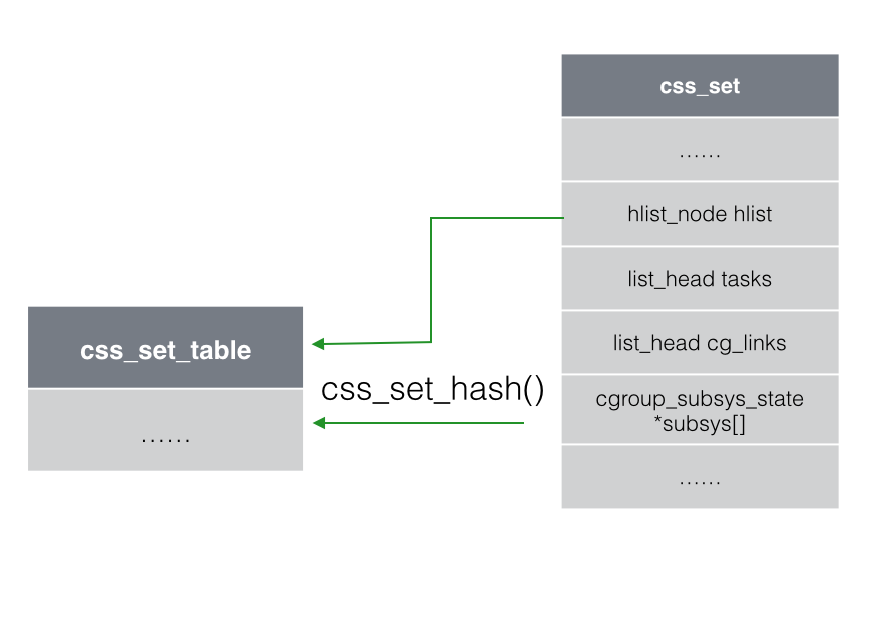

研究技术的底层原理,非常有助于来使用这项新技术

Docker使用Go语言实现

Docker利用linux内核的几个特性来实现功能:

- Namespaces: 命名空间

- Control Groups: 控制组

- Union File Systems: 联合文件系统

这也就意味着Docker只能在linux上运行. 在windows, MacOS上运行Docker, 其实本质上是借助了虚拟化技术, 然后在linux虚拟机上运行的Docker程序.

Docker Engine将namespace , cgroups, UnionFS进行组合后的一个package, 就是一个容器格式(Container Format). Docker通过对这个package中的namespace, cgroups, UnionFS进行管理控制实现容器的创建和生命周期管理

容器格式(Container Format)有多种, 其中DOcker目前使用的容器格式被称为libcontainer

- 进程号隔离:每个容器内裕兴的第一个进程, 进程号总是从1开始起算

- 网络隔离: 容器的网络与宿主机或其他容器的网络是隔离的, 分开的, 也就是相当于两个网络

- 进程间通信隔离:容器中的进程与素质及或其他容器中的进程是互相不可见的, 通信需要借助网络

- 文件系统挂载隔离: 容器拥有自己单独的工作目录

- 内核以及系统版本号隔离: 容器查看内核版本号或者系统版本号时, 查看的是容器的, 而非宿主机的

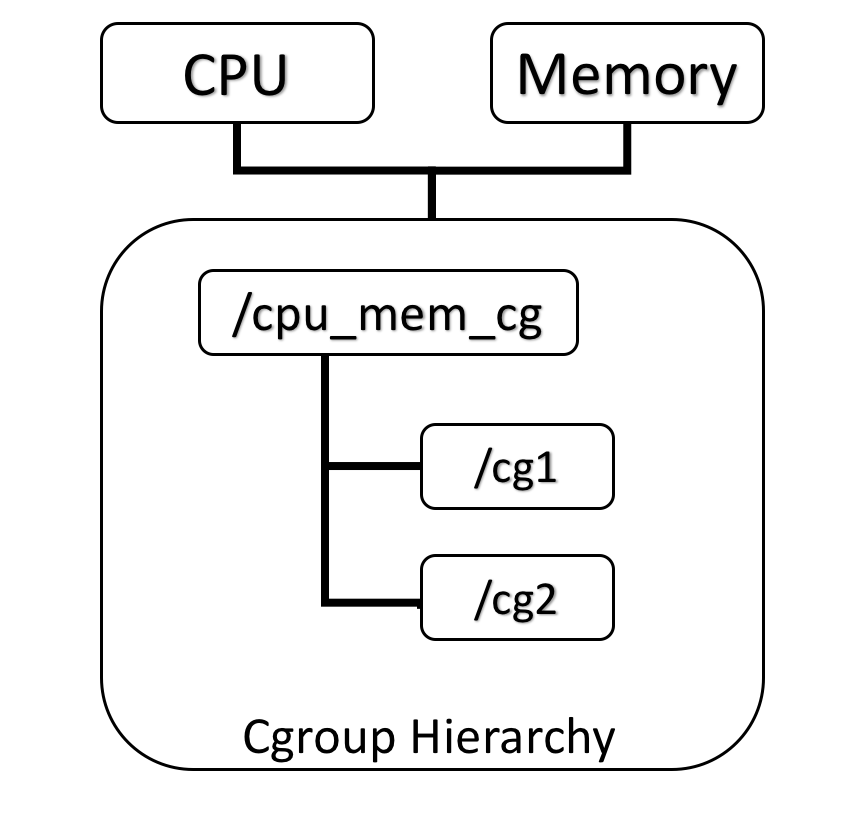

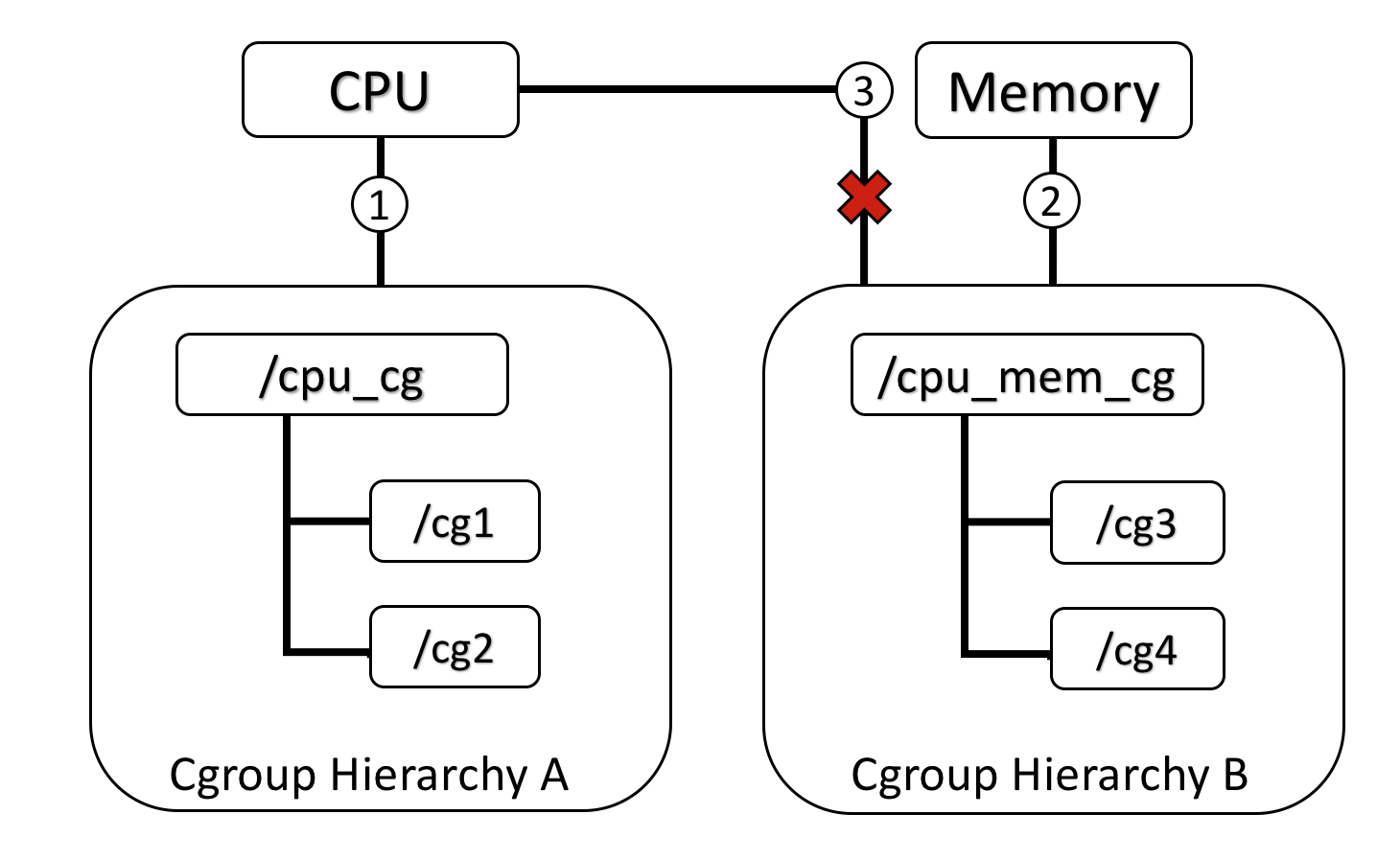

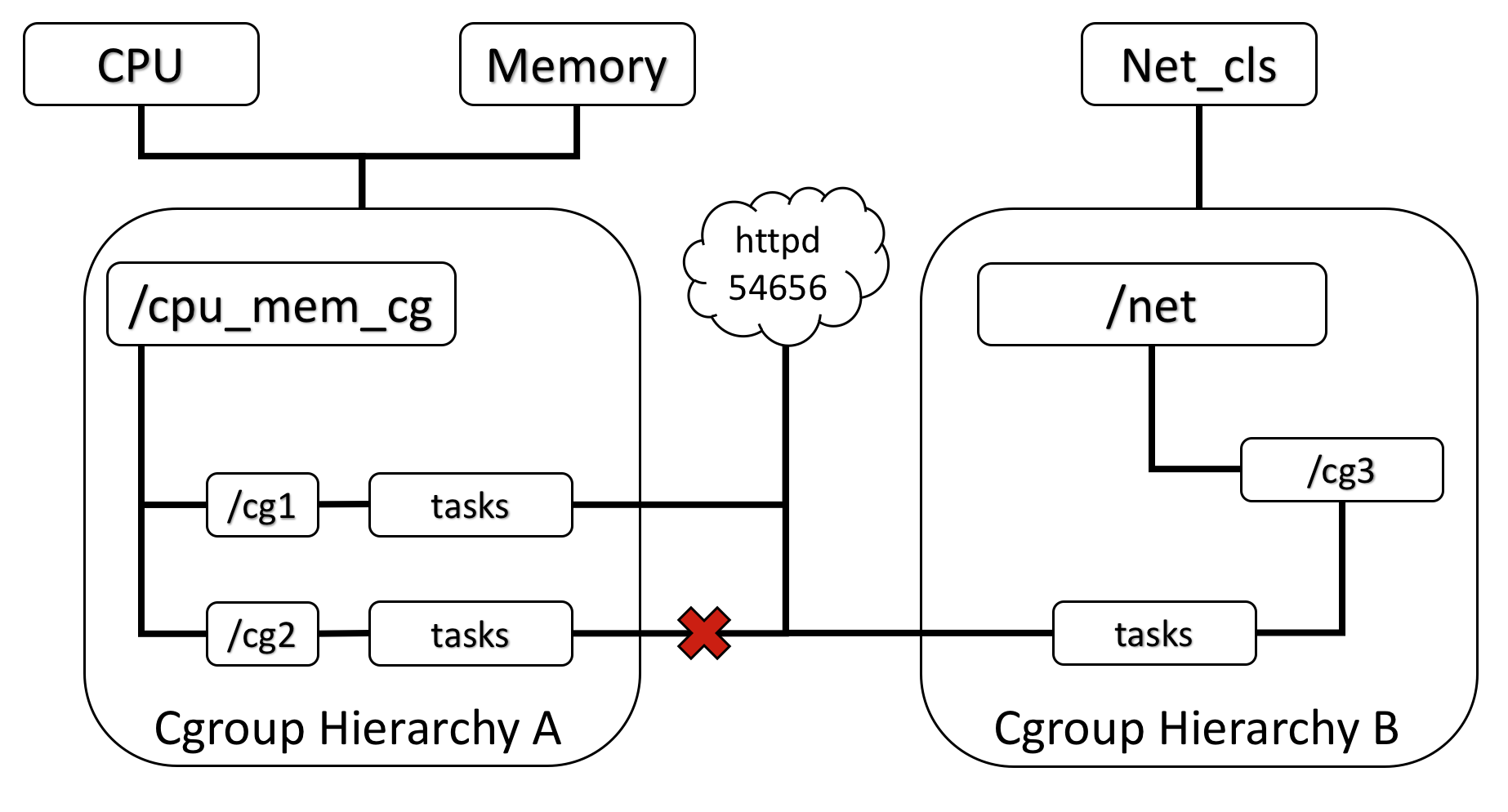

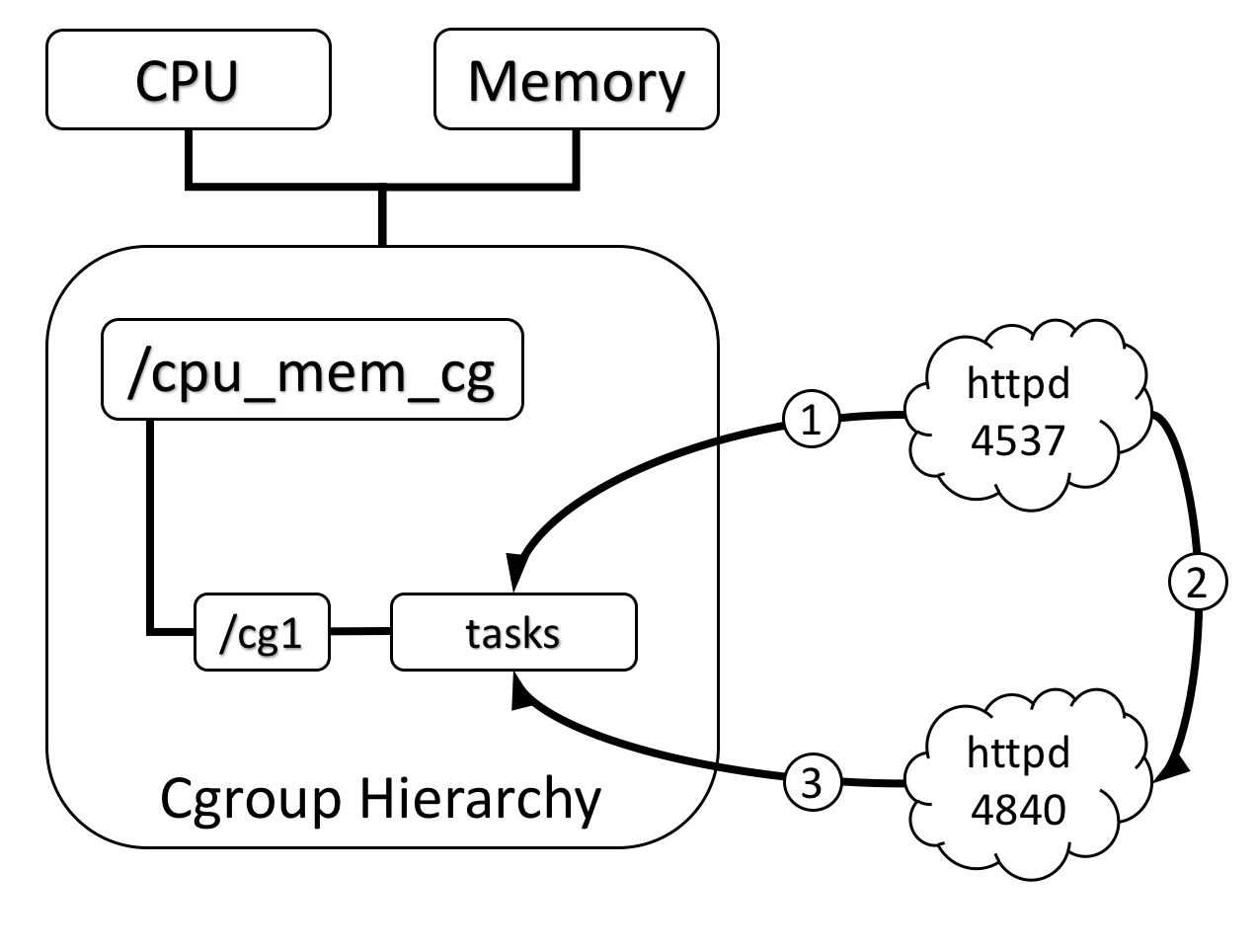

- 控制组能控制应用程序所使用的硬件资源

- 基于该性质, 控制组帮助docker引擎将硬件资源共享给容器使用, 并且加以约束和限制. 如控制容器所使用的内存大小

在计算机中,虚拟化(英语:Virtualization)是一种资源管理技术,是将计算机的各种 实体资源,如服务器、网络、内存及存储等,予以抽象、转换后呈现出来,打破实体结构间 的不可切割的障碍,使用户可以比原本的组态更好的方式来应用这些资源。这些资源的新虚拟部份是不受现有资源的架设方式,地域或物理组态所限制。一般所指的虚拟化资源包括计算能力和资料存储。

在实际的生产环境中,虚拟化技术主要用来解决高性能的物理硬件产能过剩和老的旧的 硬件产能过低的重组重用,透明化底层物理硬件,从而最大化的利用物理硬件 对资源充 分利用

虚拟化技术种类分类: 软件虚拟化, 硬件虚拟化, 内存虚拟化, 网络虚拟化, 桌面虚拟化, 服务虚拟化, 虚拟机 ...

虚拟机的监视器(hypervisor)是类似于用户的应用程序运行在主机的 OS 之上,如 VMware 的 workstation,这种虚拟化产品提供了虚拟的硬件。

硬件层的虚拟化具有高性能和隔离性,因为 hypervisor 直接在硬件上运行,有利于控制 VM 的 OS 访问硬件资源,使用这种解决方案的产品有 VMware ESXi 和 Xen server

Hypervisor 是一种运行在物理服务器和操作系统之间的中间软件层,可允许多个操作系统和应用共享一套基础物理硬件,因此也可以看作是虚拟环境中的** “元”操作系统**,它可以 协调访问服务器上的所有物理设备和虚拟机,也叫虚拟机监视器(Virtual Machine Monitor, VMM)。

Hypervisor 是所有虚拟化技术的核心。当服务器启动并执行 Hypervisor 时,它会给每一 台虚拟机分配适量的内存、CPU、网络和磁盘,并加载所有虚拟机的客户操作系统。 宿主 机

**Hypervisor 是所有虚拟化技术的核心,软硬件架构和管理更高效、更灵活,硬件的效能 能够更好地发挥出来。**常见的产品有: VMware、KVM、Xen 等等。

在计算机的世界中,容器拥有一段漫长且传奇的历史。容器与管理程序虚拟化 (hypervisor virtualization,HV)有所不同,

- 管理程序虚拟化通过中间层将一台或者多台独立的机器虚拟运行于物理硬件之上,

- 而容器则是直接运行在操作系统内核之上的用户空间。

因 此,容器虚拟化也被称为“操作系统级虚拟化”,容器技术可以让多个独立的用户空间运行在同一台宿主机上。

由于“客居”于操作系统,容器只能运行与底层宿主机相同或者相似的操作系统,这看起来并不是非常灵活。例如:可以在 Ubuntu 服务中运行 Redhat Enterprise Linux,但无法再 Ubuntu 服务器上运行 Microsoft Windows。

相对于彻底隔离的管理程序虚拟化,容器被认为是不安全的。而反对这一观点的人则认为,由于虚拟容器所虚拟的是一个完整的操作系统,这无疑增大了攻击范围,而且还要考虑 管理程序层潜在的暴露风险。

尽管有诸多局限性,容器还是被广泛部署于各种各样的应用场合。在超大规模的多租户 服务部署、轻量级沙盒以及对安全要求不太高的隔离环境中,容器技术非常流行。最常见的 一个例子就是“权限隔离监牢”(chroot jail),它创建一个隔离的目录环境来运行进程。 如果权限隔离监牢正在运行的进程被入侵者攻破,入侵者便会发现自己“身陷囹圄”,因为 权限不足被困在容器所创建的目录中,无法对宿主机进一步破坏。

最新的容器技术引入了 OpenVZ、Solaris Zones 以及 Linux 容器(LXC)。使用这些新技 术,容器不在仅仅是一个单纯的运行环境。在自己的权限类内,容器更像是一个完整的宿主 机。对 Docker 来说,它得益于现代 Linux 特性,如控件组(control group)、命名空间 (namespace)技术,容器和宿主机之间的隔离更加彻底,容器有独立的网络和存储栈,还 拥有自己的资源管理能力,使得同一台宿主机中的多个容器可以友好的共存。

容器被认为是精益技术,因为容器需要的开销有限。和传统虚拟化以及半虚拟化相比, 容器不需要模拟层(emulation layer)和管理层( hypervisor layer),而是使用操作系统的系统调用接口。这降低了运行单个容器所需的开销,也使得宿主机中可以运行更多的容器。

尽管有着光辉的历史,容器仍未得到广泛的认可。一个很重要的原因就是容器技术的复 杂性:容器本身就比较复杂,不易安装,管理和自动化也很困难。而 Docker 就是为了改变这一切而生的。

本质上的区别

server 硬件

宿主机 host os

硬件抽象层 (cpu 内存 vm 软件)

vm os 虚拟机(运行)

依赖环境

程序

而docker因为docker engine的原因: 使用能复用就复用的原则:直接调用宿主机, 不会完全隔离, 还是会有相对应的隔离. 两个应用之间的依赖还能复用

VM 体型庞大, 运行速度慢

Docker相比VM具备尺寸更小, 启动速度更快, 整合性更强(集成性更好)

1)上手快

用户只需要几分钟,就可以把自己的程序“Docker 化”。Docker 依赖于“写时复制” (copy-on-write)模型,使修改应用程序也非常迅速,可以说达到“随心所致,代码即改” 的境界。

随后,就可以创建容器来运行应用程序了。大多数 Docker 容器只需要不到 1 秒中即可 启动。由于去除了管理程序的开销,Docker 容器拥有很高的性能,同时同一台宿主机中也 可以运行更多的容器 ,使用户尽可能的充分利用系统资源。

2)职责的逻辑分类

使用 Docker,开发人员只需要关心容器中运行的应用程序,而运维人员只需要关心如 何管理容器。Docker 设计的目的就是要加强开发人员写代码的开发环境与应用程序要部署 的生产环境一致性。从而降低那种“开发时一切正常,肯定是运维的问题(测试环境都是正 常的,上线后出了问题就归结为肯定是运维的问题)”

3)快速高效的开发生命周期

Docker 的目标之一就是缩短代码从开发、测试到部署、上线运行的周期,让你的应用 程序具备可移植性,易于构建,并易于协作。( 通俗一点说,Docker 就像一个盒子,里面 可以装很多物件,如果需要这些物件的可以直接将该大盒子拿走,而不需要从该盒子中一件 件的取。)

4)鼓励使用面向服务的架构

Docker 还鼓励面向服务的体系结构和微服务架构。Docker 推荐单个容器只运行一个应 用程序或进程,这样就形成了一个分布式的应用程序模型,在这种模型下,应用程序或者服 务都可以表示为一系列内部互联的容器,从而使分布式部署应用程序,扩展或调试应用程序 都变得非常简单,同时也提高了程序的内省性。( 当然,可以在一个容器中运行多个应用程 序)

- 一致的运行环境:Docker 的镜像提供了除内核外完整的运行时环境,确保了应用运行环境一致性,从而不会再出现“这段代码在我机器上没问题啊”这类问题。

- 更快速的启动时间:可以做到秒级、甚至毫秒级的启动时间。大大的节约了开发、测试、部署的时间。

- 隔离性:避免公用的服务器,资源会容易受到其他用户的影响。

- 弹性伸缩,快速扩展:善于处理集中爆发的服务器使用压力。

- 迁移方便:可以很轻易的将在一个平台上运行的应用,迁移到另一个平台上,而不用担心运行环境的变化导致应用无法正常运行的情况。

- 持续交付和部署:使用Docker可以通过定制应用镜像来实现持续集成、持续交付、部署。

docker中最最重要的两个概念: 镜像(image) , 容器(container)

运行起来的镜像就是容器, 容器间相互隔离

Docker 是一个客户端-服务器(C/S)架构程序。Docker 客户端只需要向 Docker 服务器 或者守护进程发出请求,服务器或者守护进程将完成所有工作并返回结果。Docker 提供了 一个命令行工具 Docker 以及一整套 RESTful API。你可以在同一台宿主机上运行 Docker 守护 进程和客户端,也可以从本地的 Docker 客户端连接到运行在另一台宿主机上的远程 Docker 守护进程。

镜像是构建 Docker 的基石。用户基于镜像来运行自己的容器。镜像也是 Docker 生命周 期中的“构建”部分。镜像是基于联合文件系统的一种层式结构,由一系列指令一步一步构 建出来。例如:

添加一个文件;

执行一个命令;

打开一个窗口。

也可以将镜像当作容器的“源代码”。镜像体积很小,非常“便携”,易于分享、存储和更 新。

Docker 用 Registry 来保存用户构建的镜像。Registry 分为公共和私有两种。Docker 公司 运营公共的 Registry 叫做 Docker Hub。用户可以在 Docker Hub 注册账号,分享并保存自己的 镜像(说明:在 Docker Hub 下载镜像巨慢,可以自己构建私有的 Registry)。

Docker 可以帮助你构建和部署容器,你只需要把自己的应用程序或者服务打包放进容 器即可。容器是基于镜像启动起来的,容器中可以运行一个或多个进程。我们可以认为,镜像是Docker生命周期中的构建或者打包阶段,而容器则是启动或者执行阶段。 容器基于 镜像启动,一旦容器启动完成后,我们就可以登录到容器中安装自己需要的软件或者服务。

所以 Docker 容器就是: 一个镜像格式; 一些列标准操作; 一个执行环境。

Docker 借鉴了标准集装箱的概念。标准集装箱将货物运往世界各地,Docker 将这个模 型运用到自己的设计中,唯一不同的是:集装箱运输货物,而 Docker 运输软件。

和集装箱一样,Docker 在执行上述操作时,并不关心容器中到底装了什么,它不管是 web 服务器,还是数据库,或者是应用程序服务器什么的。所有的容器都按照相同的方式将 内容“装载”进去。

Docker 也不关心你要把容器运到何方:我们可以在自己的笔记本中构建容器,上传到 Registry,然后下载到一个物理的或者虚拟的服务器来测试,在把容器部署到具体的主机中。 像标准集装箱一样,Docker 容器方便替换,可以叠加,易于分发,并且尽量通用。

使用 Docker,我们可以快速的构建一个应用程序服务器、一个消息总线、一套实用工 具、一个持续集成(CI) 测试环境或者任意一种应用程序、服务或工具。我们可以在本地构 建一个完整的测试环境,也可以为生产或开发快速复制一套复杂的应用程序栈。

容器提供了隔离性,结论是,容器可以为各种测试提供很好的沙盒环境。并且,容器本

身就具有“标准性”的特征,非常适合为服务创建构建块。Docker 的一些应用场景如下:

- 加速本地开发和构建流程,使其更加高效、更加轻量化。本地开发人员可以构建、 运行并分享 Docker 容器。* 容器可以在开发环境中构建,然后轻松的提交到测试环境中,并 最终进入生产环境。*

- 能够让独立的服务或应用程序在不同的环境中,得到相同的运行结果。这一点在 面向服务的架构和重度依赖微型服务的部署由其实用。

- 用 Docker 创建隔离的环境来进行测试。例如,用 Jenkins CI 这样的持续集成工具 启动一个用于测试的容器。

- Docker 可以让开发者先在本机上构建一个复杂的程序或架构来进行测试,而不是 一开始就在生产环境部署、测试。

Docker 镜像是由文件系统叠加而成(是一种文件的存储形式)。最底端是一个文件引 导系统,即 bootfs,这很像典型的 Linux/Unix 的引导文件系统。Docker 用户几乎永远不会和 引导系统有什么交互。实际上,当一个容器启动后,它将会被移动到内存中,而引导文件系统则会被卸载,以留出更多的内存供磁盘镜像使用。Docker 容器启动是需要一些文件的, 而这些文件就可以称为 Docker 镜像。

**Docker 把应用程序及其依赖,打包在 image 文件里面。**只有通过这个文件,才能生成 Docker 容器。**image 文件可以看作是容器的模板 **。Docker 根据 image 文件生成容器的实例。同一个 image 文件,可以生成多个同时运行的容器实例。

image 是二进制文件。实际开发中,一个 image 文件往往通过继承另一个 image 文件,加上一些个性化设置而生成。举例来说,你可以在 Ubuntu 的 image 基础上,往里面加入 Apache 服务器,形成你的 image。

image 文件是通用的,一台机器的 image 文件拷贝到另一台机器,照样可以使用。一般来说,为了节省时间,我们应该尽量使用别人制作好的 image 文件,而不是自己制作。即使要定制,也应该基于别人的 image 文件进行加工,而不是从零开始制作。

为了方便共享,image 文件制作完成后,可以上传到网上的仓库。Docker 的官方仓库 Docker Hub 是最重要、最常用的 image 仓库。此外,出售自己制作的 image 文件也是可以的。

docker 命令其实是都对应有REST API端点, 本质上是与Docker的守护进程交互

镜像是一个Docker的可执行文件, 其中包括运行应用程序所需的所有代码内容, 依赖库, 环境变量和配置文件.

通过镜像可以创建一个或多个容器.

系统镜像(ubuntu):常被用来指定一些bash命令

应用镜像(redis, mysql): 启动一些服务

# 镜像搜索

docker search [OPTIONS] COMMAND

docker search --no-trunc ubuntu

# 列出和查看本地镜像

docker images [OPTIONS] [REPOSOTRY[:TAG]]

docker image ls [OPTIONS] [REPOSITORY[:TAG]]

docker image ls -a - REPOSITORY:镜像所在的仓库名称 带斜线的是非官方上传镜像

- TAG:镜像标签

- IMAGEID:镜像ID

- CREATED:镜像的创建日期(不是获取该镜像的日期)

- SIZE:镜像大小

为了区分同一个仓库下的不同镜像,Docker 提供了一种称为标签(Tag)的功能。每个 镜像在列出来时都带有一个标签,例如latest、 12.10、12.04 等等。每个标签对组成特定镜像的一 些镜像层进行标记(比如,标签 12.04 就是对所有 Ubuntu12.04 镜像层的标记)。这种机制 使得同一个仓库中可以存储多个镜像。--- 版本号

我们在运行同一个仓库中的不同镜像时,可以通过在仓库名后面加上一个冒号和标签名 来指定该仓库中的某一具体的镜像,例如 docker run --name custom_container_name –i –t docker.io/ubunto:12.04 /bin/bash,表明从镜像 Ubuntu:12.04 启动一个容器,而这个镜像的操 作系统就是 Ubuntu:12.04。在构建容器时指定仓库的标签也是一个好习惯。

Docker维护了镜像仓库,分为共有和私有两种,共有的官方仓库Docker Hub(https://hub.docker.com/) 是最重要最常用的镜像仓库。私有仓库(Private Registry)是开发者或者企业自建的镜像存储库,通常用来保存企业 内部的 Docker 镜像,用于内部开发流程和产品的发布、版本控制。

要想获取某个镜像,我们可以使用pull命令,从仓库中拉取镜像到本地,如

docker image pull library/hello-world上面代码中,docker image pull是抓取 image 文件的命令。library/hello-world是 image 文件在仓库里面的位置,其中library是

image 文件所在的组,hello-world是 image 文件的名字。

由于 Docker 官方提供的 image 文件,都放在library

组里面,所以它的是默认组,可以省略。因此,上面的命令可以写成下面这样。

# 拉取镜像

docker pull [OPTIONS] NAME[:TAG|@DIGEST]

docker image pull hello-world# 删除镜像

docker rmi [OPTIONS] IMAGE/ID

docker image rm [OPTIONS] NAME | ID

docker image rm 镜像名或镜像id

# 用法示例(可同时删除多个镜像)

docker image rm -f hello-world ubuntu

-f, --force 强制删除作用: 将本地的一个或多个镜像打包成本地tar文件(输出到STDOUT)

# 命令格式

docker save [OPTIONS] IMAGE [IMAGE2]

# 用法示例(多个镜像会打包成一个文件)

docker save -o linux_images.tar centos ubuntu

# 可选参数

-o, --output string 指定写入的文件名和路径

将save命令打包的镜像导入本地镜像库中

# 命令格式

docker load [OPTIONS]

docker load -i linux_images.tar -q

# 可选参数

-i, --input string 指定要打入的文件, 如果没有指定, 默认是STDIN

-q, --quiet 静默导入, 不打印导入过程信息对本地镜像的NAME, TAG进行重命名, 并新产生一个命名后的镜像

# 命令格式

docker tag source_IMAGE[:TAG] TARGET_IMAGE[:TAG]

#用法示例

docker tag e934 centos-new:newtag查看本地一个或多个镜像的详细信息

# 命令格式

docker image inspect IMAGE [IMAGE2]

docker inspect IMAGE [IMAGE2]

# 用法示例

docker image inspect centos

docker image inspect -f "{{.Architecture}}" redis

docker inspect -f "{{json .ID}}" centosdocker history Show the history of an image

作用: 查看本地一个镜像的历史(历史分层)信息

# 语法格式

docker history [OPTIONS] IMAGE

# 可选参数

--format string Pretty-print images using a Go template

-H, --human Print sizes and dates in human readable format (default true)

--no-trunc Don't truncate output

-q, --quiet Only show numeric IDs

# 用法示例

docker history ubuntudocker image prune -f容器相关的命令 container关键字几乎都可以忽略

比如 docker inspect = docker container inspect

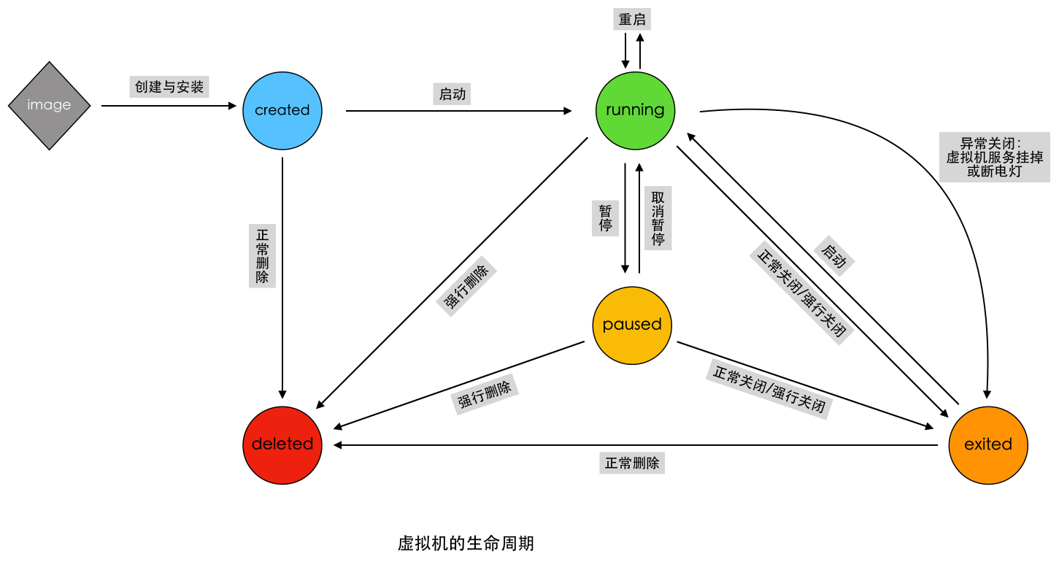

容器(Container):容器是一种轻量级、可移植、并将应用程序进行的打包的技术,使应用程序可以在几乎任何地方以相同的方式运行

•Docker将镜像文件运行起来后,产生的对象就是容器。容器相当于是镜像运行起来的一个实例。

•容器具备一定的生命周期。

•另外,可以借助docker ps命令查看运行的容器,如同在linux上利用ps命令查看运行着的进程那样。

•容器和虚拟机一样,都会对物理硬件资源进行共享使用。

•容器和虚拟机的生命周期比较相似(创建、运行、暂停、关闭等等)。

•容器中或虚拟机中都可以安装各种应用,如redis、mysql、nginx等。也就是说,在容器中的操作,如同在一个虚拟机(操作系统)中操作一样。

•同虚拟机一样,容器创建后,会存储在宿主机上:linux上位于/var/lib/docker/containers下

注意:容器并不是虚拟机,尽管它们有很多相似的地方

•虚拟机的创建、启动和关闭都是基于一个完整的操作系统。一个虚拟机就是一个完整的操作系统。**而容器直接运行在宿主机的内核上,其本质上以一系列进程的结合。 **

•容器是轻量级的,虚拟机是重量级的。首先容器不需要额外的资源来管理(不需要Hypervisor、Guest OS) ,虚拟机需要额外更多的性能消耗;其次创建、启动或关闭容器,如同创建、启动或者关闭进程那么轻松,而创建、启动、关闭一个操作系统就没那么方便了。

•也因此,意味着在给定的硬件上能运行更多数量的容器,甚至可以直接把Docker运行在虚拟机上。

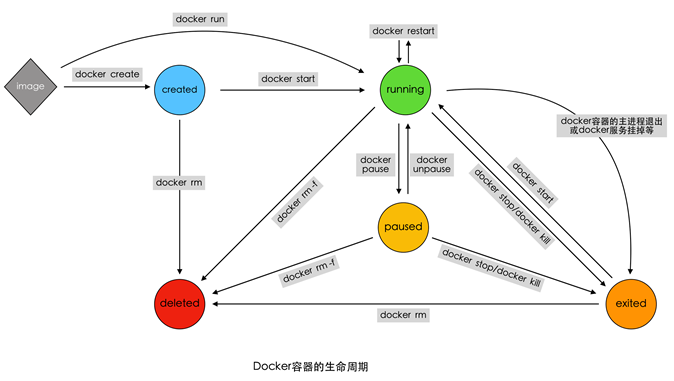

Created Running Exited Restarting

镜像是根据层级结构(layer)搭建起来的, 层级之间通过指针产生联系, 必须有过更改才会产生新的layer, 文件系统发生了更改就会产生新的层级, 每一层layer就是一个文件系统, 镜像的底层实现是只读文件系统

默认只能查看到最新的一层文件

image: unioned read-only file system

一系列只读联合文件系统, docker可以访问这个文件系统

create 命令会创建一个可读可写层文件系统(write-read layer), 位于镜像层的上方, 当执行docker commit命令后, 会将该( read-write layer)锁定为read layer 产生新的镜像

通过 docker ps 只能查看 read-write layer 层的联合可读写文件系统(镜像层会被显示为虚拟内存)

容器是基于镜像所形成的联合文件系统

联合文件系统 配合 Process Space 运行, 通过命令和操作产生新的文件, 存入 可读写文件层

New file to be found in the read-write top layer

docker 利用了集装箱的思想 不断的堆积, 底层可以不断的被复用

https://docs.docker.com/reference/cli/docker/

docker pull --platform linux/amd64 node:20https://docs.docker.com/reference/cli/docker/buildx/build/#build-arg

使用 docker buildx build

docker build --build-arg A=1 --build-arg B=2

docker buildx build --build-arg HTTP_PROXY=http://10.20.30.2:1234 --build-arg FTP_PROXY=http://40.50.60.5:4567 .# 多平台构建

docker buildx build --platform linux/amd64,linux/arm64 .

# 多构建参数

docker buildx build --build-arg HTTP_PROXY=http://10.20.30.2:1234 --build-arg FTP_PROXY=http://40.50.60.5:4567 .只是创建了容器, 并没有运行(被创建状态)

docker create: Create a new container

应用场景 / 作用:

利用(基于)镜像创建出一个Created状态的待启动容器

# 语法格式

docker create [OPTIONS] IMAGE [COMMAND] [ARG...]

# command: 启动容器后需要在容器中执行的命令

# arguments: 执行命令时需要用到的参数

# 用法示例

docker create --name test-container centos ps -A

docker create -it --name testcontainer2 centos /bin/bash•命令参数(OPTIONS):查看更多

-t, --tty 分配一个伪TTY, 也就是分配虚拟终端(进入容器的命令行)

-i, --interactive 即使没有连接,也要保持STDIN(standard input)打开

--name 为容器命名,如果没有指定将会随机产生一个名称

•命令参数(COMMAND\ARG):

COMMAND表示容器启动后,需要在容器中执行的命令,如ps、ls 等命令

ARG表示执行 COMMAND 时需要提供的一些参数,如ps 命令的 aux、ls命令的-a等等

docker start Start one or more stopped containers

应用场景/作用: 将一个或多个处于创建或关闭状态的容器启动起来

# 语法格式

docker start [OPTIONS] CONTAINER [CONTAINER...]

# 可选参数

-a, --attach Attach STDOUT/STDERR and forward signals # 将当前shell的STDOUT/STDERR连接到容器上

--detach-keys string Override the key sequence for detaching a container

-i, --interactive "Attach container's STDIN" # 将当前shell的STDIN连接到容器上

# 用法示例

docker start -i my_redis

>>> root@4b66edbad2fe:/data# ls

docker start -a 1aac2527b6eadocker run Run a command in a new container

作用: 利用基于镜像创建并启动一个容器

# 覆盖CMD

docker run ... echo hello world

docker run --rm ubuntu pwd

docker run --rm --gpus all nvidia/cuda:12.4.1-cudnn-devel-ubuntu22.04 nvidia-smi# 语法格式/用法

docker run [option] 镜像名 [向启动容器中传入的命令]

docker run [OPTIONS] IMAGE [COMMAND] [ARG...]

# 可选参数

Options:

--add-host list Add a custom host-to-IP mapping (host:ip)

-a, --attach list Attach to STDIN, STDOUT or STDERR

--blkio-weight uint16 Block IO (relative weight), between 10 and 1000, or 0 to disable (default 0)

--blkio-weight-device list Block IO weight (relative device weight) (default [])

--cap-add list Add Linux capabilities

--cap-drop list Drop Linux capabilities

--cgroup-parent string Optional parent cgroup for the container

--cidfile string Write the container ID to the file

--cpu-period int Limit CPU CFS (Completely Fair Scheduler) period

--cpu-quota int Limit CPU CFS (Completely Fair Scheduler) quota

--cpu-rt-period int Limit CPU real-time period in microseconds

--cpu-rt-runtime int Limit CPU real-time runtime in microseconds

-c, --cpu-shares int CPU shares (relative weight)

--cpus decimal Number of CPUs

--cpuset-cpus string CPUs in which to allow execution (0-3, 0,1)

--cpuset-mems string MEMs in which to allow execution (0-3, 0,1)

-d, --detach Run container in background and print container ID

--detach-keys string Override the key sequence for detaching a container

--device list Add a host device to the container

--device-cgroup-rule list Add a rule to the cgroup allowed devices list

--device-read-bps list Limit read rate (bytes per second) from a device (default [])

--device-read-iops list Limit read rate (IO per second) from a device (default [])

--device-write-bps list Limit write rate (bytes per second) to a device (default [])

--device-write-iops list Limit write rate (IO per second) to a device (default [])

--disable-content-trust Skip image verification (default true)

--dns list Set custom DNS servers

--dns-option list Set DNS options

--dns-search list Set custom DNS search domains

--domainname string Container NIS domain name

--entrypoint string Overwrite the default ENTRYPOINT of the image

-e, --env list Set environment variables

--env-file list Read in a file of environment variables

--expose list Expose a port or a range of ports

--gpus gpu-request GPU devices to add to the container ('all' to pass all GPUs)

--group-add list Add additional groups to join

--health-cmd string Command to run to check health

--health-interval duration Time between running the check (ms|s|m|h) (default 0s)

--health-retries int Consecutive failures needed to report unhealthy

--health-start-period duration Start period for the container to initialize before starting health-retries countdown (ms|s|m|h) (default 0s)

--health-timeout duration Maximum time to allow one check to run (ms|s|m|h) (default 0s)

--help Print usage

-h, --hostname string Container host name

--init Run an init inside the container that forwards signals and reaps processes

-i, --interactive Keep STDIN open even if not attached

--ip string IPv4 address (e.g., 172.30.100.104)

--ip6 string IPv6 address (e.g., 2001:db8::33)

--ipc string IPC mode to use

--isolation string Container isolation technology

--kernel-memory bytes Kernel memory limit

-l, --label list Set meta data on a container

--label-file list Read in a line delimited file of labels

--link list Add link to another container

--link-local-ip list Container IPv4/IPv6 link-local addresses

--log-driver string Logging driver for the container

--log-opt list Log driver options

--mac-address string Container MAC address (e.g., 92:d0:c6:0a:29:33)

-m, --memory bytes Memory limit

--memory-reservation bytes Memory soft limit

--memory-swap bytes Swap limit equal to memory plus swap: '-1' to enable unlimited swap

--memory-swappiness int Tune container memory swappiness (0 to 100) (default -1)

--mount mount Attach a filesystem mount to the container

--name string Assign a name to the container

--network network Connect a container to a network

--network-alias list Add network-scoped alias for the container

--no-healthcheck Disable any container-specified HEALTHCHECK

--oom-kill-disable Disable OOM Killer

--oom-score-adj int Tune host's OOM preferences (-1000 to 1000)

--pid string PID namespace to use

--pids-limit int Tune container pids limit (set -1 for unlimited)

--privileged Give extended privileges to this container

-p, --publish list Publish a container's port(s) to the host

-P, --publish-all Publish all exposed ports to random ports

--read-only Mount the container's root filesystem as read only

--restart string Restart policy to apply when a container exits (default "no")

--rm Automatically remove the container when it exits

--runtime string Runtime to use for this container

--security-opt list Security Options

--shm-size bytes Size of /dev/shm

--sig-proxy Proxy received signals to the process (default true)

--stop-signal string Signal to stop a container (default "SIGTERM")

--stop-timeout int Timeout (in seconds) to stop a container

--storage-opt list Storage driver options for the container

--sysctl map Sysctl options (default map[])

--tmpfs list Mount a tmpfs directory

-t, --tty Allocate a pseudo-TTY

--ulimit ulimit Ulimit options (default [])

-u, --user string Username or UID (format: <name|uid>[:<group|gid>])

--userns string User namespace to use

--uts string UTS namespace to use

-v, --volume list Bind mount a volume

--volume-driver string Optional volume driver for the container

--volumes-from list Mount volumes from the specified container(s)

-w, --workdir string Working directory inside the container

# 用法示例

docker run -it --name mytest redis

docker run -d redis

docker run -d --rm redis

docker run -d --rm --name haha redis echo 'haha'

-e TZ=Aisa/Shanghai

常用可选参数说明:

- -i,--interactive 即使没有连接, 也要保持STDIN表示以“交互模式”运行容器

- -t,--tty 表示容器启动后会进入其命令行。加入这两个参数后, 容器创建就能登录进去。即分配一个伪终端。

- --name string 为创建的容器命名

- -v 表示目录映射关系(前者是宿主机目录,后者是映射到宿主机上的目录,即 宿主机目录:容器中目录),可以使 用多个-v 做多个目录或文件映射。注意:最好做目录映射,在宿主机上做修改,然后 共享到容器上。

- -d 在run后面加上-d参数,则会创建一个守护式容器在后台运行(这样创建容器后不 会自动登录容器,如果只加-i -t 两个参数,创建后就会自动进去容器)。

- -p 表示端口映射,前者是宿主机端口,后者是容器内的映射端口。可以使用多个-p 做多个端口映射

- -e 为容器设置环境变量

- -h 指定主机名

- --network=host 表示将主机的网络环境映射到容器中,容器的网络与主机相同

- --rm 当容器退出运行后,自动删除容器

例如,创建一个交互式容器,并命名为myubuntu

docker run -it --name=myubuntu ubuntu /bin/bash在容器中可以随意执行linux命令,就是一个ubuntu的环境,当执行exit命令退出时,该容器也随之停止。

创建一个守护式容器:如果对于一个需要长期运行的容器来说,我们可以创建一个守护式容器。在容器内部exit退出时,容器也不会停止。

docker run -dit --name=myubuntu2 ubuntu# 两种创建方式的区别

docker run 相当于 docker create + docker start -a 前台模式

docker run -d 相当于 docker create + docker start 后台模式docker pause Pause all processes within one or more containers

作用: 暂停一个或多个处于运行状态的容器

# 语法格式 Usage

docker pause CONTAINER [CONTAINER...]

# 用法示例 Examples

docker ps -a

# CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS

# 95bcadb01c10 redis "docker-entrypoint.s…" 17 minutes ago Up 17 minutes 6379/tcp

docker pause 95bcadb01c10 4b66edbad2fe

docker ps -a

# CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS

# 95bcadb01c10 redis "docker-entrypoint.s…" 18 minutes ago Up 18 minutes (Paused) 6379/tcp

docker unpause Unpause all processes within one or more containers

作用: 取消一个或多个处于暂停状态的容器, 恢复运行

# 语法格式 Usage

docker unpause CONTAINER [CONTAINER...]

# 用法示例 Examples

docker unpause 95bcadb01c10 docker stop Stop one or more running containers

作用: 关闭一个或多个处于暂停或运行状态的容器

# 语法格式 Usage

docker stop [OPTIONS] CONTAINER [CONTAINER...]

docker stop 容器名或容器id

# 可选参数 Options

-t,--time int Seconds to wait for stop before killing it (default 10) # 关闭前等待数秒(默认10S)

# 用法示例 Examples

docker ps -a

docker stop 4b66edbad2fe 95bcadb01c10

docker ps -a | grep -e 4b66edbad2fe -e 95bcadb01c10

# kill掉一个已经在运行的容器

docker kill 容器名或容器iddocker kill Kill one or more running containers

强制并立即关闭处于暂停或运行状态的容器

# 语法格式 Usage

docker kill [OPTIONS] CONTAINER [CONTAINER...]

#可选参数 OPTIONS

-s, --signal string Signal to send to the container (default "KILL") # 指定发送给容器的关闭信号

# 用法示例 Examples

docker kill hahaha

前提知识点:

Linux其中两种终止进程的信号是:SIGTERM和SIGKILL

- SIGKILL信号:无条件终止进程信号。进程接收到该信号会立即终止,不进行清理和暂存工作。该信号不能被忽略、处理和阻塞,它向系统管理员提供了可以杀死任何进程的方法。

- SIGTERM信号:程序终结信号,可以由kill命令产生。与SIGKILL不同的是,SIGTERM信号可以被阻塞和终止 ,以便程序在退出前可以保存工作或清理临时文件等。

docker stop 会先发出SIGTERM信号给进程,告诉进程即将会被关闭。在-t指定的等待时间过了之后,将会立即发出SIGKILL信号,直接关闭容器。

docker kill 直接发出SIGKILL信号关闭容器。但也可以通过-s参数修改发出的信号。

因此会发现在docker stop的等过过程中,如果终止docker stop的执行,容器最终没有被关闭。而docker kill几乎是立刻发生,无法撤销。

此外还有些异常原因也会导致容器被关闭,比如docker daemon重启、容器内部进程运行发生错误等等“异常原因”。

docker restart Restart one or more containers

作用: 重启一个或多个处于运行状态、暂停状态、关闭状态或者新建状态的容器

该命令相当于stop和start命令的结合

# 语法格式 Usage

docker restart [OPTIONS] CONTAINER [CONTAINER...]

# 可选参数 Options

-t, --time int Seconds to wait for stop before killing the container (default 10) # 终止容器前等待数秒

# 用法示例 Examples

docker restart hahaha mytest

docker rm Remove one or more containers

作用: 删除一个或多个容器

# 语法格式 Usage

docker rm [OPTIONS] CONTAINER [CONTAINER...]

docker container rm 容器名或容器id

# 可选参数 OPTIONS

-f, --force Force the removal of a running container (uses SIGKILL) # 强行删除容器(向容器发送SIGKILL信号)

-l, --link Remove the specified link

-v, --volumes Remove the volumes associated with the container # 同时删除绑定在容器上的数据卷

# 用法示例 Examples

docker rm -f fervent_blackwell objective_khayyam sleepy_mirzakhani admiring_neumanndocker rename Rename a container

作用: 修改容器的名称

# 语法格式

docker rename CONTAINER NEW_NAME

# 用法示例

docker rename hahaha my_redis

docker attach Attach local standard input, output, and error streams to a running container

作用: 将当前终端的STDIN、STDOUT、STDERR绑定到正在运行的容器的主进程上实现连接

# 语法格式

docker attach [OPTIONS] CONTAINER

# 可选参数

--detach-keys string Override the key sequence for detaching a container

--no-stdin Do not attach STDIN

--sig-proxy Proxy all received signals to the process (default true)

运行中的容器执行命令, 容器中执行新命令

docker exec Run a command in a running container

作用: 向运行中的容器执行命令, 用于执行维护工作

# 语法格式

docker exec -it 容器名或容器id 进入后执行的第一个命令

# 可选参数

-d, --detach Detached mode: run command in the background # 后台运行命令

--detach-keys string Override the key sequence for detaching a container

-e, --env list Set environment variables # 设置容器运行时的环境变量

-i, --interactive Keep STDIN open even if not attached # 保持STDIN绑定, 即使没有连接容器

--privileged Give extended privileges to the command

-t, --tty Allocate a pseudo-TTY # 分配一个虚拟终端

-u, --user string Username or UID (format: <name|uid>[:<group|gid>])

-w, --workdir string Working directory inside the container # 指定容器中运行时的环境变量

# 用法示例

docker exec -it myubuntu2 /bin/bashdocker ps List containers

作用: 列出正在运行的容器

# 列出本机正在运行的容器

docker ps [OPTIONS]

docker container ls | ps | list [OPTIONS]

# 可选参数 OPTIONS

-a, --all Show all containers (default shows just running)

-f, --filter filter Filter output based on conditions provided

--format string Pretty-print containers using a Go template

-n, --last int Show n last created containers (includes all states) (default -1)

-l, --latest Show the latest created container (includes all states)

--no-trunc Don't truncate output

-q, --quiet Only display numeric IDs

-s, --size Display total file sizes

# 列出本机所有容器,包括已经终止运行的

docker container ls --all

docker ps -asdocker inspect Return low-level information on Docker objects

作用: 查看容器的低层级详细信息

# 语法格式 Usage

docker inspect [OPTIONS] NAME|ID [NAME|ID...]

# 可选参数 OPTIONS

-f, --format string Format the output using the given Go template

-s, --size Display total file sizes if the type is container

--type string Return JSON for specified type

# 用法示例 Examples

docker inspect hahaha -s

docker inspect --format='{{.LogPath}}' redis

docker logs Fetch the logs of a container

作用: 查看容器的日志信息

注意: 容器日志中记录的是容器主进程的输出 STDOUT \ STDERR

# 语法格式 Usage

docker logs [OPTIONS] CONTAINER

# 可选参数

--details Show extra details provided to logs # 显示日志的额外信息

-f, --follow Follow log output # 动态跟踪显示日志信息

--since string Show logs since timestamp (e.g. 2013-01-02T13:23:37) or relative (e.g. 42m for 42 minutes)

--tail string Number of lines to show from the end of the logs (default "all")

-t, --timestamps Show timestamps

--until string Show logs before a timestamp (e.g. 2013-01-02T13:23:37) or relative (e.g. 42m for 42 minutes)

docker top

作用: 查看容器中的进程的信息

# 语法格式 Usage

docker top CONTAINER [ps OPTIONS]连接两个容器, 创建一个网络, 然后分别将他们链接到该网络中

也可以在创建(run)容器时设置network, 当两个容器网络相同时则表示二则在同一个网络环境下

同一网络下各自的地址默认是该容器的名称

docker network create [OPTIONS] NETWORK

# Connect a container to a network

docker network connect [OPTION] NETWORK CONTAINER

从容器中创建一个新的镜像, 提交容器为镜像

docker commit Create a new image from a container's changes

作用: 根据容器生成一个新的镜像

# 语法格式

docker commit [OPTIONS] CONTAINER [REPOSITORY[:TAG]]

# 可选参数 Options:

-a, --author string Author (e.g., "John Hannibal Smith <hannibal@a-team.com>") # 指定作者信息

-c, --change list Apply Dockerfile instruction to the created image # 为创建的镜像加入dockerfile命令

-m, --message string Commit message # 提交信息 类似git commit -m

-p, --pause Pause container during commit (default true) # 提交时暂停容器

# 用法示例

docker pull ubuntu:disco

docker images

docker run --rm -dti ubuntu:disco bash

docker exec -d 62d7 apt install tree # 62d7 为容器id

docker commit -m "install tree" 62d7 mytest:latest

docker images

docker history mytest:latest查看docker容器进程的资源占用率

docker export Export a container's filesystem as a tar archive

作用: 将容器的文件系统导出为一个tar包存档

# 语法格式

docker export [OPTIONS] CONTAINER

# 可选参数

-o, --output string Write to a file, instead of STDOUT # 导出到一个文件, 而非标准输出流(STDOUT)

# 用法示例

docker export -o test_container.tar 62d71文件应该是 容器tar文件, 由

docker export命令导出, 应该注意区分容器tar文件 和镜像tar文件

docker import Import the contents from a tarball to create a filesystem image

作用: 从一个tar文件中导入内容, 创建一个镜像

# 语法格式

docker import [OPTIONS] file|URL|- [REPOSITORY[:TAG]]

# 可选参数

-c, --change list Apply Dockerfile instruction to the created image

-m, --message string Set commit message for imported image

# 用法示例

cat exampleimage.tgz | docker import - exampleimagelocal:ne w

docker import nginx-test.tar nginx:test

优先推荐使用commit方法

通过查看两个镜像的历史信息可知

commit是继承, import是合并后重建

commit会保留父镜像的元数据, import则需要重写

scan 扫描本地镜像隐患

docker volume ls

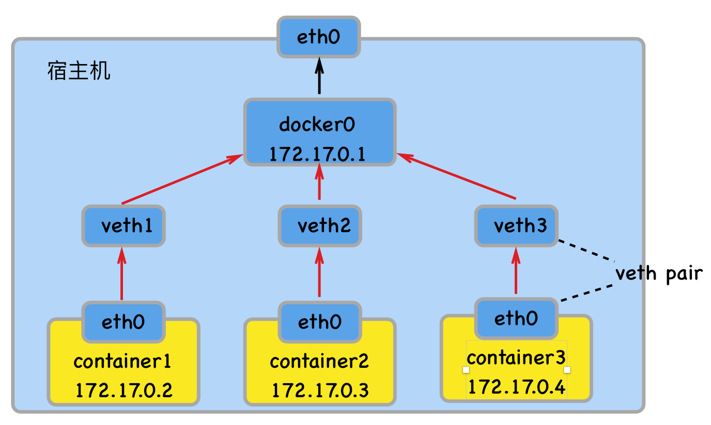

docker 容器的网络默认与宿主机、与其他容器都是相互隔离。

•容器中可以运行一些网络应用(如nginx、web应用、数据库等),如果要让外部也可以访问这些容器内运行的网络应用,那么就需要配置网络来实现。

•有可能有的需求下,容器不想让它的网络与宿主机、与其他容器隔离。

•有可能有的需求下,容器根本不需要网络。

•有可能有的需求下,容器需要更高的定制化网络(如定制特殊的集群网络、定制容器间的局域网)。

•有可能有的需求下, 容器数量特别多,体量很大的一系列容器的网络管理如何

•……

因此容器的网络管理是非常重要的

Docker有五种网络驱动模式

•bridge network 模式(网桥):默认的网络模式。类似虚拟机的nat模式

•host network 模式(主机):容器与宿主机之间的网络无隔离,即容器直接使用宿主机网络

•None network 模式:容器禁用所有网络。

•Overlay network 模式(覆盖网络): 利用VXLAN实现的bridge模式

•Macvlan network 模式:容器具备Mac地址,使其显示为网络上的物理设备

docker network ls List networks

作用: 列出&查看已经建立的网络对象

注意: 默认情况下, docker安装完成后, 会自动创建bridge, host, none三种网络驱动

# 语法格式

docker network ls [OPTIONS]

# 可选参数

-f, --filter filter Provide filter values (e.g. 'driver=bridge')

--format string Pretty-print networks using a Go template

--no-trunc Do not truncate the output

-q, --quiet Only display network IDs

# 用法示例

docker network create create a network

作用: 创建新的网路对象

注意:

host 和 none 模式网络只能存在一个

docker自带的overlay网络创建依赖于docker swarm(集群负载均衡)服务

192.168.0.0/16 等于 192.168.0.0~192.168.255.255 192.168.8.0/24

172.88.0.0/24 等于172.88.0.0~172.88.0.255

# 语法格式

docker network create [OPTIONS] NETWORK

# 可选参数

--attachable Enable manual container attachment

--aux-address map Auxiliary IPv4 or IPv6 addresses used by Network driver (default map[])

--config-from string The network from which copying the configuration

--config-only Create a configuration only network

-d, --driver string Driver to manage the Network (default "bridge") # 指定网络的驱动(默认: bridge)

--gateway strings IPv4 or IPv6 Gateway for the master subnet # 子网的IPv4 or IPv6网关, 如(192.168.0.1)

--ingress Create swarm routing-mesh network

--internal Restrict external access to the network

--ip-range strings Allocate container ip from a sub-range # 执行容器的IP范围, 格式同subnet参数

--ipam-driver string IP Address Management Driver (default "default")

--ipam-opt map Set IPAM driver specific options (default map[])

--ipv6 Enable IPv6 networking

--label list Set metadata on a network

-o, --opt map Set driver specific options (default map[])

--scope string Control the network's scope

--subnet strings Subnet in CIDR format that represents a network segment # 指定子网网段(192.168.0.0/16)

# 用法示例

network create -d bridge my-bridgedocker network rm Remove one or more networks

作用: 删除一个或多个网络

# 语法格式

docker network rm NETWORK [NETWORK...]

# 可选参数

Aliases:

rm, remove

# 用法示例

docker network rm my-bridgedocker network inspect Display detailed information on one or more networks

作用: 查看一个或多个网络的详细信息

# 语法格式

docker network inspect [OPTIONS] NETWORK [NETWORK...]

# 可选参数

-f, --format string Format the output using the given Go template

-v, --verbose Verbose output for diagnostics

# 用法示例

docker network inspect bridgedocker run --network Connect a container to a network

作用: 为启动的容器指定网络模式

注意: 默认情况下,docker创建或启动容器时,会默认使用名为bridge的网络

docker network connect/disconnect Connect/Disconnect a container to a network

作用: 将指定容器与指定网络进行连接或者断开连接

# 语法格式

docker network connect [OPTIONS] NETWORK CONTAINER

# 可选参数

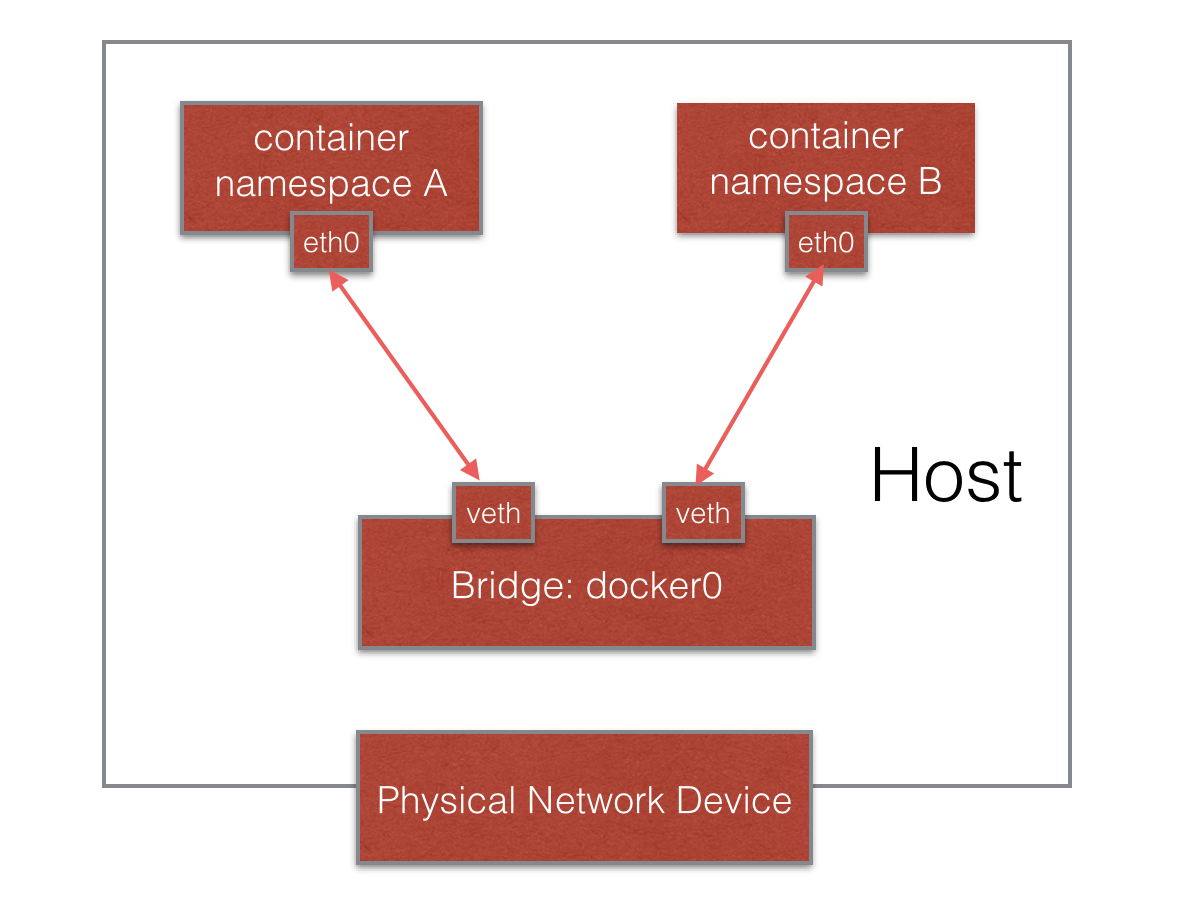

-f, --force 强制断开连接(用于disconnect)特点:

- 宿主机上需要单独的bridge网卡,如默认docker默认创建的docker0。

- 容器之间、容器与主机之间的网络通信,是借助为每一个容器生成的一对veth pair虚拟网络设备对,进行通信的。一个在容器上,另一个在宿主机上。

- 每创建一个基于bridge网络的容器,都会自动在宿主机上创建一个veth**虚拟网络设备。

- 外部无法直接访问容器。需要建立端口映射才能访问。

- 容器借由veth虚拟设备通过如docker0这种bridge网络设备进行通信。 每一容器具有单独的IP

作用: 启动的容器时,为容器进行端口映射 命令格式: docker run/create -P … 或者 docker run/create –p … 命令参数(OPTIONS): -P, --publish-all 将容器内部所有暴露端口进行随机映射 -p, --publish list 手动指定端口映射 注意: -p [HOST_IP]:[HOST_PORT]:CONTAINER_PORT 如:-p ::80 将容器的80端口随机(端口)映射到宿主机任意IP -p :8000:6379 将容器的6379端口映射到宿主机任意IP的8000端口 -p 192.168.5.1::3306 将容器的3306端口随机(端口)映射到宿主机的192.168.5.1IP上

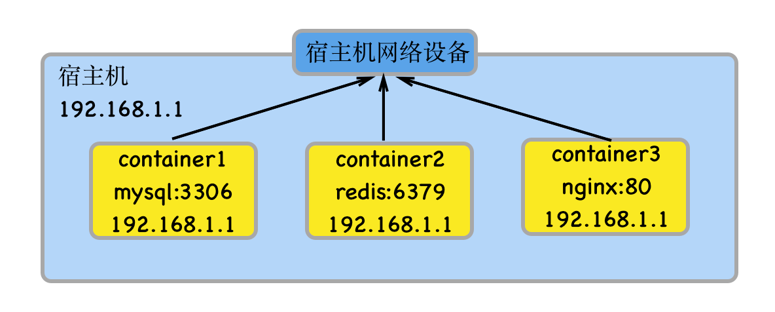

- 容器完全共享宿主机的网络。网络没有隔离。宿主机的网络就是容器的网络。

- 容器、主机上的应用所使用的端口不能重复。例如:如果宿主机已经占用了8090端口,那么任何一个host模式的容器都不可以使用8090端口了;反之同理。

- 外部可以直接访问容器,不需要端口映射。

- 容器的IP就是宿主机的IP

•Container网络模式,其实就是容器共享其他容器的网络。

•相当于该容器,,在网络层面上,将其他容器作为“主机”。它们之间的网络没有隔离。

•这些容器之间的特性同host模式。

使用方法:

Docker run/create --network container:CONTAINER …

特点:

•容器上没有网络,也无任何网络设备。

•如果需要使用网络,需要用户自行安装与配置。

应用场景: 该模式适合需要高度定制网络的用户使用。

•Overlay 网络,也称为覆盖网络。

•Overlay 网络的实现方式和方案有多种。Docker自身集成了一种,基于VXLAN隧道技术实现。

•Overlay 网络主要用于实现跨主机容器之间的通信。

应用场景:需要管理成百上千个跨主机的容器集群的网络时。

IP隧道网络原理

•macvlan网络模式,最主要的特征就是他们的通信会直接基于mac地址进行转发。

•这时宿主机其实充当一个二层交换机。Docker会维护着一个MAC地址表,当宿主机网络收到一个数据包后,直接根据mac地址找到对应的容器,再把数据交给对应的容器。

•容器之间可以直接通过IP互通,通过宿主机上内建的虚拟网络设备(创建macvlan网络时自动创建),但与主机无法直接利用IP互通。

应用场景:由于每个外来的数据包的目的mac地址就是容器的mac地址,这时每个容器对于外面网络来说就相当于一个真实的物理网络设备。因此当需要让容器来的网络看起来是一个真实的物理机时,使用macvlan模式

挂载, 联合文件系统

有三种方式来进行数据存储管理: 共享数据, 数据容器,

Bind mounts,

-

宿主机无法直接访问容器中的文件

-

容器中的文件没有持久化,导致容器删除后,文件数据也随之消失

-

容器之间也无法直接访问互相的文件

解决方案

为解决这些问题,docker加入了数据卷(volumes)机制,能很好解决上面问题,以实现:

-

容器与主机之间、容器与容器之间共享文件

-

容器中数据的持久化

-

将容器中的数据备份、迁移、恢复等

-

数据卷存在于宿主机的文件系统中,独立于容器,和容器的生命周期是分离的。

-

数据卷可以目录也可以是文件,容器可以利用数据卷与宿主机进行数据共享,实现了容器间的数据共享和交换。

-

容器启动初始化时,如果容器使用的镜像包含了数据,这些数据会拷贝到数据卷中。

-

容器对数据卷的修改是实时进行的。

-

数据卷的变化不会影响镜像的更新。数据卷是独立于联合文件系统,镜像是基于联合文件系统。镜像与数据卷之间不会有相互影响。

Docker的数据卷更多会是使用volumes方式来进行使用。使用时需注意:

-

如果挂载一个空的数据卷到容器中的一个非空目录中,那么这个目录下的文件会被复制到数据卷中。

-

如果挂载一个非空的数据卷到容器中的一个目录中,那么容器中的目录中会显示数据卷中的数据。如果原来容器中的目录中有数据,那么这些原始数据会被隐藏掉。

这两个规则都非常重要,灵活利用第一个规则可以帮助我们初始化数据卷中的内容。掌握第二个规则可以保证挂载数据卷后的数据总是你期望的结果。

一般推荐volumes

- bind mounts:将宿主机上的一个文件或目录被挂载到容器上。

- volumes:由Docker创建和管理。使用docker volume命令管理

- tmpfs mounts:tmpfs 是一种基于内存的临时文件系统。tmpfs mounts 数据不会存储在磁盘上。

利用docker run/create的参数为容器挂载数据卷

方式一: -v, --volume参数

-v 宿主机文件或文件夹路径**:**容器中的文件或者文件夹路径

方式二:--mount参数

--mount type=bind, src**=宿主机文件或文件夹路径,** dst**=**容器中的文件或者文件夹路径

注意:指定的文件和路径必须提前创建或存在

docker run -v /data /test/webserver•利用docker run/create为容器挂载数据卷

•用法:

方式一: -v, --volume参数

**-v VOLUME-NAME:**容器中的文件或者文件夹路径

方式二:--mount 参数

--mount type=volume, src**=VOLUME-NAME,** dst**=**容器中的文件或者文件夹路径

•volume对象管理:

# 使用方法

docker volume 命令管理volume数据卷对象

docker volume create 创建数据卷对象

docker volume inspect 查看数据卷详细信息

docker volume ls 查看已创建的数据卷对象

docker volume prune 删除未被使用的数据卷对象

docker volume rm 删除一个或多个数据卷对象•利用docker run/create 的--volumes-from参数指定数据卷容器

•用法:

docker run/create --volumes-from CONTAINER

作用: 基于已有镜像创建镜像, 一般容器只作为环境使用, 不推荐在运行容器时安装软件, 因为在容器停止后所有数据会丢失,

语法说明: 非常类似于 shell 命令, 基本思路完全一致

使用dockerfile创建开发环境思路:

开发环境应该是构建好的, 而不是运行容器时构建!

# 安装时 不安装recommend

apt-get install -y --no-install-recommends

# 移除apt 安装缓存

rm -rf /var/lib/apt/lists/*

# 禁用package更新

`apt-mark hold ${NV_CUDNN_PACKAGE_NAME}`

# 安装pip 禁用缓存

pip install --no-cache-dir -r requirements.txt

- 基本思路: 编写好

Dockerfile文件 >> 通过docker build创建镜像 >> 创建容器 >> 连接容器/镜像

Docker指南: Dockerfile是一个描述如何创建Docker镜像所需步骤的文本文件

Dockerfile其实就是根据特定的语法格式撰写出来的一个普通的文本文件

利用docker build命令依次执行在Dockerfile中定义的一系列命令,最终生成一个新的镜像(定制镜像)

GitHub search path:Dockerfile path:docker-compose

# 最常见的是将代码复制到 app或code目录

# 而Go这样的二进制文件则一般直接放在PATH相关的目录中, 或者 创建用户 放到 用户文件夹中

WORKDIR /app /code /src /project-name /app-name

# 安装更新和必要package

RUN <<EOF

apt-get update

apt-get install -y --no-install-recommends git

EOF

# 创建用户和组

RUN <<EOF

useradd -s /bin/bash -m vscode

groupadd docker

usermod -aG docker vscode

EOF# 将其他阶段构建的文件复制到新的stage中

COPY --from=builder /app/myapp .USAGE

# 环境变量

ADD

ARG # 定义普通变量

CMD # 执行命令(脚本), 通常启动服务

COPY # 复制文件到container

ENV # 设置环境变量

EXPOSE # 暴露端口

FROM <image>[:<tag>] [as <name>] # 初始化镜像

LABEL

RUN

STOPSIGNAL

USER

VOLUME

WORKDIR # 设置工作目录, 如果存在则创建

ONBUILDhe docker build command builds an image from

a Dockerfile and a context. The build’s context is the set of files at a specified location PATH or URL.

The PATH is a directory on your local filesystem. The URL is a Git repository location.

A context is processed recursively. So, a PATH includes any subdirectories and the URL includes the repository and

its submodules. This example shows a build command that uses the current directory as context:

$ docker build .

Sending build context to Docker daemon 6.51 MB

...

The build is run by the Docker daemon, not by the CLI. The first thing a build process does is send the entire context ( recursively) to the daemon. In most cases, it’s best to start with an empty directory as context and keep your Dockerfile in that directory. Add only the files needed for building the Dockerfile.

Warning: Do not use your root directory,

/, as thePATHas it causes the build to transfer the entire contents of your hard drive to the Docker daemon.

To use a file in the build context, the Dockerfile refers to the file specified in an instruction, for example,

a COPY instruction. To increase the build’s performance, exclude files and directories by adding a .dockerignore

file to the context directory. For information about how

to create a .dockerignore file see the

documentation on this page.

Traditionally, the Dockerfile is called Dockerfile and located in the root of the context. You use the -f flag

with docker build to point to a Dockerfile anywhere in your file system.

$ docker build -f /path/to/a/dockerfile .

You can specify a repository and tag at which to save the new image if the build succeeds:

$ docker build -t shykes/myapp .

To tag the image into multiple repositories after the build, add multiple -t parameters when you run the build

command:

$ docker build -t shykes/myapp:1.0.2 -t shykes/myapp:latest .

Before the Docker daemon runs the instructions in the Dockerfile, it performs a preliminary validation of

the Dockerfile and returns an error if the syntax is incorrect:

$ docker build -t test/myapp .

Sending build context to Docker daemon 2.048 kB

Error response from daemon: Unknown instruction: RUNCMD

The Docker daemon runs the instructions in the Dockerfile one-by-one, committing the result of each instruction to a

new image if necessary, before finally outputting the ID of your new image. The Docker daemon will automatically clean

up the context you sent.

Note that each instruction is run independently, and causes a new image to be created - so RUN cd /tmp will not have

any effect on the next instructions.

Whenever possible, Docker will re-use the intermediate images (cache), to accelerate the docker build process

significantly. This is indicated by the Using cache message in the console output. (For more information, see

the Build cache section in

the Dockerfile best practices guide):

$ docker build -t svendowideit/ambassador .

Sending build context to Docker daemon 15.36 kB

Step 1/4 : FROM alpine:3.2

---> 31f630c65071

Step 2/4 : MAINTAINER SvenDowideit@home.org.au

---> Using cache

---> 2a1c91448f5f

Step 3/4 : RUN apk update && apk add socat && rm -r /var/cache/

---> Using cache

---> 21ed6e7fbb73

Step 4/4 : CMD env | grep _TCP= | (sed 's/.*_PORT_\([0-9]*\)_TCP=tcp:\/\/\(.*\):\(.*\)/socat -t 100000000 TCP4-LISTEN:\1,fork,reuseaddr TCP4:\2:\3 \&/' && echo wait) | sh

---> Using cache

---> 7ea8aef582cc

Successfully built 7ea8aef582ccBuild cache is only used from images that have a local parent chain. This means that these images were created by

previous builds or the whole chain of images was loaded with docker load. If you wish to use build cache of a specific

image you can specify it with --cache-from option. Images specified with --cache-from do not need to have a parent

chain and may be pulled from other registries.

When you’re done with your build, you’re ready to look into Pushing a repository to its registry.

# FROM <image>[:<tag> | @<digest>] [as <name>]

#

ARG VERSION=latest

FROM ubuntu:$VERSION

# ARG 显然的, 参数应该在 FROM 之前

基础镜像可能并未安装某些命令,

使用 \ 和 ; 来组织命令, 下面两种写法相同

RUN <command> # shell form 推荐

RUN ["executable", "param1", "param2"] # exec form

# 用法示例

RUN /bin/bash -c ' source $HOME/.bashrc; \

echo $HOME'

RUN /bin/bash -c 'source $HOME/.bashrc; echo $HOME'

RUN ["/bin/bash", "-c", "echo hello"]

# 多行命令

RUN <<EOF

useradd -s /bin/bash -m vscode

groupadd docker

usermod -aG docker vscode

EOF

# 方式二 次选 -S --system

RUN <<EOF

addgroup -S docker

adduser -S --shell /bin/bash --ingroup docker vscode

EOF作用: CMD的主要作用是为 正在执行的容器提供默认命令. The main purpose of a CMD is to provide defaults for an

executing container.

重要提示:一个dockerfile只能有一条CMD命令, 当有多条命令时, 仅最后一条命令将会生效.

CMD ["executable", "param1", "param2"] # exec form 推荐

CMD ["param1", "param2"] # as default parameters toENTRYPOINT

CMD command param1 param2 # shell form为镜像添加元数据, 一个LABEL 其实是一个键值对. 使用引号来包含空格, 使用反斜杠进行换行.

The LABEL instruction adds metadata to an image. A LABEL is a key-value pair. To include spaces within a LABEL

value, use quotes and backslashes as you would in command-line parsing.

一个镜像可以包含多个 LABEL , 也可以在一行指定多个标签.

LABEL <key>=<value> <key>=<value> <key>=<value>

# 用法示例

LABEL "com.example.vendor"="ACME Incorporated"

LABEL com.example.label-with-value="foo"

LABEL version="1.0"

LABEL description="This text illustrates \

that label-values can span multiple lines."expose 暴露, 端口暴露

EXPOSE 指令告诉 Docker 容器在运行时监听指定端口.

The EXPOSE instruction informs Docker that the container listens on the specified network ports at runtime. You can

specify whether the port listens on TCP or UDP, and the default is TCP if the protocol is not specified.

EXPOSE <port> [<port>/<protocol>...]

# 用法示例

EXPOSE 80/tcp

EXPOSE 80/udpIn this case, if you use -P with docker run, the port will be exposed once for TCP and once for UDP. Remember

that -P uses an ephemeral high-ordered host port on the host, so the port will not be the same for TCP and UDP.

Regardless of the EXPOSE settings, you can override them at runtime by using the -p flag. For example

docker run -p 80:80/tcp -p 80:80/udp ...To set up port redirection on the host system,

see using the -P flag. The docker network

command supports creating networks for communication among containers without the need to expose or publish specific

ports, because the containers connected to the network can communicate with each other over any port. For detailed

information, see the overview of this feature).

ENV 指令为环境变量赋值(当前文件的环境变量). 这个值段将会对应后续的所有指令在构建阶段有效

The ENV instruction sets the environment variable to the value. This value will be in the environment for all

subsequent instructions in the build stage and can

be replaced inline in many as well.

第一种形式下, 第一个空格后面的所有字符串将作为value

The ENV instruction has two forms. The first form, ENV , will set a single variable to a value. The entire string

after the first space will be treated as the <value> - including whitespace characters. The value will be interpreted

for other environment variables, so quote characters will be removed if they are not escaped.

第二种形式下:支持两种字符串形式: "" 和 \space

The second form, ENV <key>=<value> ..., allows for multiple variables to be set at one time. Notice that the second

form uses the equals sign (=) in the syntax, while the first form does not. Like command line parsing, quotes and

backslashes can be used to include spaces within values.

ENV <key> <value>

ENV <key>=<value> <key>=<value> ...

# 用法示例 `\ ` 表示空格

ENV myName="John Doe" myDog=Rex\ The\ Dog \

myCat=fluffy

ENV myName John Doe

ENV myDog Rex The Dog

ENV myCat fluffy

ADD指令从src新文件,目录和链接 复制并添加 到dest镜像的文件系统

The ADD instruction copies new files, directories or remote file URLs from src and adds them to the filesystem of

the image at the path dest.

Multiple `` resources may be specified but if they are files or directories, their paths are interpreted as relative to the source of the context of the build.

Each `` may contain wildcards and matching will be done using Go’s filepath.Match rules.

ADD [--chown=<user>:<group>] <src>...<dest>

ADD [--chown=<user>:<group>] ["<src>",... "<dest>"] # 这种情况适用于路径包含空格的情况

# 用法示例

ADD hom* /mydir/ # adds all files starting with "hom"

ADD hom?.txt /mydir/ # ? is replaced with any single character, e.g., "home.txt"

ADD test relativeDir/ # adds "test" to `WORKDIR`/relativeDir/

ADD test /absoluteDir/ # adds "test" to /absoluteDir/

ADD --chown=55:mygroup files* /somedir/

ADD --chown=bin files* /somedir/

ADD --chown=1 files* /somedir/

ADD --chown=10:11 files* /somedir/COPY

COPY指令从src : 新文件和目录 复制并添加 到dest : 镜像的文件系统

The COPY instruction copies new files or directories from src and adds them to the filesystem of the container at

the path dest.

Multiple src resources may be specified but the paths of files and directories will be interpreted as relative to the

source of the context of the build.

Each src may contain wildcards and matching will be done using

Go’s filepath.Match rules.

COPY [--chown=<user>:<group>] <src>... <dest>

COPY [--chown=<user>:<group>] ["<src>",... "<dest>"] (this form is required for paths containing whitespace)

# 用法示例

COPY hom* /mydir/ # adds all files starting with "hom"

COPY hom?.txt /mydir/ # ? is replaced with any single character, e.g., "home.txt"

COPY test relativeDir/ # adds "test" to `WORKDIR`/relativeDir/

COPY test /absoluteDir/ # adds "test" to /absoluteDir/

COPY --chown=55:mygroup files* /somedir/

COPY --chown=bin files* /somedir/

COPY --chown=1 files* /somedir/

COPY --chown=10:11 files* /somedir/ENTRYPOINT 指令指定容器在可执行状态下的启动命令

An ENTRYPOINT allows you to configure a container that will run as an executable.

For example, the following will start nginx with its default content, listening on port 80:

# 启动Nginx, 并且将监听端口绑定80端口

docker run -i -t --rm -p 80:80 nginx

ENTRYPOINT ["executable", "param1", "param2"] # (exec form, preferred)

ENTRYPOINT command param1 param2 # (shell form)

# 用法示例

FROM ubuntu

ENTRYPOINT ["top", "-b"]

CMD ["-c"]Both CMD and ENTRYPOINT instructions define what command gets executed when running a container. There are few rules

that describe their co-operation.

- Dockerfile should specify at least one of

CMDorENTRYPOINTcommands. ENTRYPOINTshould be defined when using the container as an executable.CMDshould be used as a way of defining default arguments for anENTRYPOINTcommand or for executing an ad-hoc command in a container.CMDwill be overridden when running the container with alternative arguments.

The table below shows what command is executed for different ENTRYPOINT / CMD combinations:

| No ENTRYPOINT | ENTRYPOINT exec_entry p1_entry | ENTRYPOINT [“exec_entry”, “p1_entry”] | |

|---|---|---|---|

| No CMD | error, not allowed | /bin/sh -c exec_entry p1_entry | exec_entry p1_entry |

| CMD [“exec_cmd”, “p1_cmd”] | exec_cmd p1_cmd | /bin/sh -c exec_entry p1_entry | exec_entry p1_entry exec_cmd p1_cmd |

| CMD [“p1_cmd”, “p2_cmd”] | p1_cmd p2_cmd | /bin/sh -c exec_entry p1_entry | exec_entry p1_entry p1_cmd p2_cmd |

| CMD exec_cmd p1_cmd | /bin/sh -c exec_cmd p1_cmd | /bin/sh -c exec_entry p1_entry | exec_entry p1_entry /bin/sh -c exec_cmd p1_cmd |

Note: If

CMDis defined from the base image, settingENTRYPOINTwill resetCMDto an empty value. In this scenario,CMDmust be defined in the current image to have a value.

The VOLUME instruction creates a mount point with the specified name and marks it as holding externally mounted

volumes from native host or other containers. The value can be a JSON array, VOLUME ["/var/log/"], or a plain string

with multiple arguments, such as VOLUME /var/log or VOLUME /var/log /var/db. For more information/examples and

mounting instructions via the Docker client, refer to Share Directories via

Volumes

documentation.

The docker run command initializes the newly created volume with any data that exists at the specified location within

the base image. For example, consider the following Dockerfile snippet:

VOLUME ["/data"]

# 用法示例

FROM ubuntu

RUN mkdir /myvol

RUN echo "hello world" > /myvol/greeting

VOLUME /myvolThis Dockerfile results in an image that causes docker run to create a new mount point at /myvol and copy

the greeting file into the newly created volume.

Keep the following things in mind about volumes in the Dockerfile.

- Volumes on Windows-based containers: When using Windows-based containers, the destination of a volume inside the

container must be one of:

- a non-existing or empty directory

- a drive other than

C:

- Changing the volume from within the Dockerfile: If any build steps change the data within the volume after it has been declared, those changes will be discarded.

- JSON formatting: The list is parsed as a JSON array. You must enclose words with double quotes (

") rather than single quotes ('). - The host directory is declared at container run-time: The host directory (the mountpoint) is, by its nature,

host-dependent. This is to preserve image portability, since a given host directory can’t be guaranteed to be

available on all hosts. For this reason, you can’t mount a host directory from within the Dockerfile. The

VOLUMEinstruction does not support specifying ahost-dirparameter. You must specify the mountpoint when you create or run the container.

Docker容器连接

docker run -it --link list [command]

#

FROM python:3.7

# 复制文件

COPY

# # Nginx

#

# VERSION 0.0.1

FROM ubuntu

LABEL Description="This image is used to start the foobar executable" Vendor="ACME Products" Version="1.0"

RUN apt-get update && apt-get install -y inotify-tools nginx apache2 openssh-server# Firefox over VNC

#

# VERSION 0.3

FROM ubuntu

# Install vnc, xvfb in order to create a 'fake' display and firefox

RUN apt-get update && apt-get install -y x11vnc xvfb firefox

RUN mkdir ~/.vnc

# Setup a password

RUN x11vnc -storepasswd 1234 ~/.vnc/passwd

# Autostart firefox (might not be the best way, but it does the trick)

RUN bash -c 'echo "firefox" >> /.bashrc'

EXPOSE 5900

CMD ["x11vnc", "-forever", "-usepw", "-create"]# Multiple images example

#

# VERSION 0.1

FROM ubuntu

RUN echo foo > bar

# Will output something like ===> 907ad6c2736f

FROM ubuntu

RUN echo moo > oink

# Will output something like ===> 695d7793cbe4

# You'll now have two images, 907ad6c2736f with /bar, and 695d7793cbe4 with

# /oink.# 将当前目录的所有文件服务复制到工作目录

COPY . .

# 将指定目录复制到目标目录

COPY dir ./dir/docker compose up

# 启动时并重构镜像

docker compose up --build

docker compose --env-file .env.production # 简单绑定

volumes:

- ./volumes/db/data:/var/lib/postgresql/data# mysql

# postgres

healthcheck:

test: [ "CMD", "pg_isready" ]

interval: 1s

timeout: 3s

retries: 30l

# redis

healthcheck:

test: [ "CMD", "redis-cli", "ping" ]

# 创建集群

docker swarm init --advertise-addr <MANAGER-IP>

docker swarm join- 孙健波

阅读数:333912015 年 3 月 12 日 09:23

Docker 这么火,喜欢技术的朋友可能也会想,如果要自己实现一个资源隔离的容器,应该从哪些方面下手呢?也许你第一反应可能就是 chroot 命令,这条命令给用户最直观的感觉就是使用后根目录 / 的挂载点切换了,即文件系统被隔离了。然后,为了在分布式的环境下进行通信和定位,容器必然需要一个独立的 IP、端口、路由等等,自然就想到了网络的隔离。同时,你的容器还需要一个独立的主机名以便在网络中标识自己。想到网络,顺其自然就想到通信,也就想到了进程间通信的隔离。可能你也想到了权限的问题,对用户和用户组的隔离就实现了用户权限的隔离。最后,运行在容器中的应用需要有自己的 PID, 自然也需要与宿主机中的 PID 进行隔离。

由此,我们基本上完成了一个容器所需要做的六项隔离,Linux 内核中就提供了这六种 namespace 隔离的系统调用,如下表所示。

| Namespace | 系统调用参数 | 隔离内容 |

|---|---|---|

| UTS | CLONE_NEWUTS | 主机名与域名 |

| IPC | CLONE_NEWIPC | 信号量、消息队列和共享内存 |

| PID | CLONE_NEWPID | 进程编号 |

| Network | CLONE_NEWNET | 网络设备、网络栈、端口等等 |

| Mount | CLONE_NEWNS | 挂载点(文件系统) |

| User | CLONE_NEWUSER | 用户和用户组 |

表 namespace 六项隔离

实际上,Linux 内核实现 namespace 的主要目的就是为了实现轻量级虚拟化(容器)服务。在同一个 namespace 下的进程可以感知彼此的变化,而对外界的进程一无所知。这样就可以让容器中的进程产生错觉,仿佛自己置身于一个独立的系统环境中,以此达到独立和隔离的目的。

需要说明的是,本文所讨论的 namespace 实现针对的均是 Linux 内核 3.8 及其以后的版本。接下来,我们将首先介绍使用 namespace 的 API,然后针对这六种 namespace 进行逐一讲解,并通过程序让你亲身感受一下这些隔离效果(参考自 http://lwn.net/Articles/531114/ )。

namespace 的 API 包括 clone()、setns() 以及 unshare(),还有 /proc 下的部分文件。为了确定隔离的到底是哪种 namespace,在使用这些 API 时,通常需要指定以下六个常数的一个或多个,通过|(位或)操作来实现。你可能已经在上面的表格中注意到,这六个参数分别是 CLONE_NEWIPC、CLONE_NEWNS、CLONE_NEWNET、CLONE_NEWPID、CLONE_NEWUSER 和 CLONE_NEWUTS。

使用 clone() 来创建一个独立 namespace 的进程是最常见做法,它的调用方式如下。

int clone(int (*child_func)(void *), void *child_stack, int flags, void *arg);

clone() 实际上是传统 UNIX 系统调用 fork() 的一种更通用的实现方式,它可以通过 flags 来控制使用多少功能。一共有二十多种 CLONE_* 的 flag(标志位)参数用来控制 clone 进程的方方面面(如是否与父进程共享虚拟内存等等),下面外面逐一讲解 clone 函数传入的参数。

- 参数 child_func 传入子进程运行的程序主函数。

- 参数 child_stack 传入子进程使用的栈空间

- 参数 flags 表示使用哪些 CLONE_* 标志位

- 参数 args 则可用于传入用户参数

在后续的内容中将会有使用 clone() 的实际程序可供大家参考。

从 3.8 版本的内核开始,用户就可以在 /proc/[pid]/ns 文件下看到指向不同 namespace 号的文件,效果如下所示,形如 [4026531839] 者即为 namespace 号。

$ ls -l /proc/$$/ns <<-- $$ 表示应用的 PID

total 0

lrwxrwxrwx. 1 mtk mtk 0 Jan 8 04:12 ipc -> ipc:[4026531839]

lrwxrwxrwx. 1 mtk mtk 0 Jan 8 04:12 mnt -> mnt:[4026531840]

lrwxrwxrwx. 1 mtk mtk 0 Jan 8 04:12 net -> net:[4026531956]

lrwxrwxrwx. 1 mtk mtk 0 Jan 8 04:12 pid -> pid:[4026531836]

lrwxrwxrwx. 1 mtk mtk 0 Jan 8 04:12 user->user:[4026531837]

lrwxrwxrwx. 1 mtk mtk 0 Jan 8 04:12 uts -> uts:[4026531838]

如果两个进程指向的 namespace 编号相同,就说明他们在同一个 namespace 下,否则则在不同 namespace 里面。/proc/[pid]/ns 的另外一个作用是,一旦文件被打开,只要打开的文件描述符(fd)存在,那么就算 PID 所属的所有进程都已经结束,创建的 namespace 就会一直存在。那如何打开文件描述符呢?把 /proc/[pid]/ns 目录挂载起来就可以达到这个效果,命令如下。

# touch ~/uts

# mount --bind /proc/27514/ns/uts ~/uts

如果你看到的内容与本文所描述的不符,那么说明你使用的内核在 3.8 版本以前。该目录下存在的只有 ipc、net 和 uts,并且以硬链接存在。

上文刚提到,在进程都结束的情况下,也可以通过挂载的形式把 namespace 保留下来,保留 namespace 的目的自然是为以后有进程加入做准备。通过 setns() 系统调用,你的进程从原先的 namespace 加入我们准备好的新 namespace,使用方法如下。

int setns(int fd, int nstype);

- 参数 fd 表示我们要加入的 namespace 的文件描述符。上文已经提到,它是一个指向 /proc/[pid]/ns 目录的文件描述符,可以通过直接打开该目录下的链接或者打开一个挂载了该目录下链接的文件得到。

- 参数 nstype 让调用者可以去检查 fd 指向的 namespace 类型是否符合我们实际的要求。如果填 0 表示不检查。

为了把我们创建的 namespace 利用起来,我们需要引入 execve() 系列函数,这个函数可以执行用户命令,最常用的就是调用 /bin/bash 并接受参数,运行起一个 shell,用法如下。

fd = open(argv[1], O_RDONLY); /* 获取 namespace 文件描述符 */

setns(fd, 0); /* 加入新的 namespace */

execvp(argv[2], &argv[2]); /* 执行程序 */

假设编译后的程序名称为 setns。

# ./setns ~/uts /bin/bash # ~/uts 是绑定的 /proc/27514/ns/uts

至此,你就可以在新的命名空间中执行 shell 命令了,在下文中会多次使用这种方式来演示隔离的效果。

最后要提的系统调用是 unshare(),它跟 clone() 很像,不同的是,unshare() 运行在原先的进程上,不需要启动一个新进程,使用方法如下。

int unshare(int flags);

调用 unshare() 的主要作用就是不启动一个新进程就可以起到隔离的效果,相当于跳出原先的 namespace 进行操作。这样,你就可以在原进程进行一些需要隔离的操作。Linux 中自带的 unshare 命令,就是通过 unshare() 系统调用实现的,有兴趣的读者可以在网上搜索一下这个命令的作用。

系统调用函数 fork() 并不属于 namespace 的 API,所以这部分内容属于延伸阅读,如果读者已经对 fork() 有足够的了解,那大可跳过。

当程序调用 fork()函数时,系统会创建新的进程,为其分配资源,例如存储数据和代码的空间。然后把原来的进程的所有值都复制到新的进程中,只有少量数值与原来的进程值不同,相当于克隆了一个自己。那么程序的后续代码逻辑要如何区分自己是新进程还是父进程呢?

fork() 的神奇之处在于它仅仅被调用一次,却能够返回两次(父进程与子进程各返回一次),通过返回值的不同就可以进行区分父进程与子进程。它可能有三种不同的返回值:

- 在父进程中,fork 返回新创建子进程的进程 ID

- 在子进程中,fork 返回 0

- 如果出现错误,fork 返回一个负值

下面给出一段实例代码,命名为 fork_example.c。

#include <unistd.h>

#include <stdio.h>

int main (){

pid_t fpid; //fpid 表示 fork 函数返回的值

int count=0;

fpid=fork();

if (fpid < 0)printf("error in fork!");

else if (fpid == 0) {

printf("I am child. Process id is %d/n",getpid());

}

else {

printf("i am parent. Process id is %d/n",getpid());

}

return 0;

}

编译并执行,结果如下。

root@local:~# gcc -Wall fork_example.c && ./a.out

I am parent. Process id is 28365

I am child. Process id is 28366

使用 fork() 后,父进程有义务监控子进程的运行状态,并在子进程退出后自己才能正常退出,否则子进程就会成为“孤儿”进程。

下面我们将分别对六种 namespace 进行详细解析。

UTS namespace 提供了主机名和域名的隔离,这样每个容器就可以拥有了独立的主机名和域名,在网络上可以被视作一个独立的节点而非宿主机上的一个进程。

下面我们通过代码来感受一下 UTS 隔离的效果,首先需要一个程序的骨架,如下所示。打开编辑器创建 uts.c 文件,输入如下代码。

#define _GNU_SOURCE

#include <sys/types.h>

#include <sys/wait.h>

#include <stdio.h>

#include <sched.h>

#include <signal.h>

#include <unistd.h>

#define STACK_SIZE (1024 * 1024)

static char child_stack[STACK_SIZE];

char* const child_args[] = {

"/bin/bash",

NULL

};

int child_main(void* args) {

printf("在子进程中!\n");

execv(child_args[0], child_args);

return 1;

}

int main() {

printf("程序开始: \n");

int child_pid = clone(child_main, child_stack + STACK_SIZE, SIGCHLD, NULL);

waitpid(child_pid, NULL, 0);

printf("已退出\n");

return 0;

}

编译并运行上述代码,执行如下命令,效果如下。

root@local:~# gcc -Wall uts.c -o uts.o && ./uts.o

程序开始:

在子进程中!

root@local:~# exit

exit

已退出

root@local:~#

下面,我们将修改代码,加入 UTS 隔离。运行代码需要 root 权限,为了防止普通用户任意修改系统主机名导致 set-user-ID 相关的应用运行出错。

//[...]

int child_main(void* arg) {

printf("在子进程中!\n");

sethostname("Changed Namespace", 12);

execv(child_args[0], child_args);

return 1;

}

int main() {

//[...]

int child_pid = clone(child_main, child_stack+STACK_SIZE,

CLONE_NEWUTS | SIGCHLD, NULL);

//[...]

}

再次运行可以看到 hostname 已经变化。

root@local:~# gcc -Wall namespace.c -o main.o && ./main.o

程序开始:

在子进程中!

root@NewNamespace:~# exit

exit

已退出

root@local:~# <- 回到原来的 hostname

也许有读者试着不加 CLONE_NEWUTS 参数运行上述代码,发现主机名也变了,输入 exit 以后主机名也会变回来,似乎没什么区别。实际上不加 CLONE_NEWUTS 参数进行隔离而使用 sethostname 已经把宿主机的主机名改掉了。你看到 exit 退出后还原只是因为 bash 只在刚登录的时候读取一次 UTS,当你重新登陆或者使用 uname 命令进行查看时,就会发现产生了变化。

Docker 中,每个镜像基本都以自己所提供的服务命名了自己的 hostname 而没有对宿主机产生任何影响,用的就是这个原理。

容器中进程间通信采用的方法包括常见的信号量、消息队列和共享内存。然而与虚拟机不同的是,容器内部进程间通信对宿主机来说,实际上是具有相同 PID namespace 中的进程间通信,因此需要一个唯一的标识符来进行区别。申请 IPC 资源就申请了这样一个全局唯一的 32 位 ID,所以 IPC namespace 中实际上包含了系统 IPC 标识符以及实现 POSIX 消息队列的文件系统。在同一个 IPC namespace 下的进程彼此可见,而与其他的 IPC namespace 下的进程则互相不可见。

IPC namespace 在代码上的变化与 UTS namespace 相似,只是标识位有所变化,需要加上 CLONE_NEWIPC 参数。主要改动如下,其他部位不变,程序名称改为 ipc.c。(测试方法参考自: http://crosbymichael.com/creating-containers-part-1.html )

//[...]

int child_pid = clone(child_main, child_stack+STACK_SIZE,

CLONE_NEWIPC | CLONE_NEWUTS | SIGCHLD, NULL);

//[...]

我们首先在 shell 中使用 ipcmk -Q 命令创建一个 message queue。

root@local:~# ipcmk -Q

Message queue id: 32769

通过 ipcs -q 可以查看到已经开启的 message queue,序号为 32769。

root@local:~# ipcs -q

------ Message Queues --------

key msqid owner perms used-bytes messages

0x4cf5e29f 32769 root 644 0 0

然后我们可以编译运行加入了 IPC namespace 隔离的 ipc.c,在新建的子进程中调用的 shell 中执行 ipcs -q 查看 message queue。

root@local:~# gcc -Wall ipc.c -o ipc.o && ./ipc.o

程序开始:

在子进程中!

root@NewNamespace:~# ipcs -q

------ Message Queues --------

key msqid owner perms used-bytes messages

root@NewNamespace:~# exit

exit

已退出

上面的结果显示中可以发现,已经找不到原先声明的 message queue,实现了 IPC 的隔离。

目前使用 IPC namespace 机制的系统不多,其中比较有名的有 PostgreSQL。Docker 本身通过 socket 或 tcp 进行通信。

PID namespace 隔离非常实用,它对进程 PID 重新标号,即两个不同 namespace 下的进程可以有同一个 PID。每个 PID namespace 都有自己的计数程序。内核为所有的 PID namespace 维护了一个树状结构,最顶层的是系统初始时创建的,我们称之为 root namespace。他创建的新 PID namespace 就称之为 child namespace(树的子节点),而原先的 PID namespace 就是新创建的 PID namespace 的 parent namespace(树的父节点)。通过这种方式,不同的 PID namespaces 会形成一个等级体系。所属的父节点可以看到子节点中的进程,并可以通过信号等方式对子节点中的进程产生影响。反过来,子节点不能看到父节点 PID namespace 中的任何内容。由此产生如下结论(部分内容引自: http://blog.dotcloud.com/under-the-hood-linux-kernels-on-dotcloud-part )。

- 每个 PID namespace 中的第一个进程“PID 1“,都会像传统 Linux 中的 init 进程一样拥有特权,起特殊作用。

- 一个 namespace 中的进程,不可能通过 kill 或 ptrace 影响父节点或者兄弟节点中的进程,因为其他节点的 PID 在这个 namespace 中没有任何意义。

- 如果你在新的 PID namespace 中重新挂载 /proc 文件系统,会发现其下只显示同属一个 PID namespace 中的其他进程。

- 在 root namespace 中可以看到所有的进程,并且递归包含所有子节点中的进程。

到这里,可能你已经联想到一种在外部监控 Docker 中运行程序的方法了,就是监控 Docker Daemon 所在的 PID namespace 下的所有进程即其子进程,再进行删选即可。

下面我们通过运行代码来感受一下 PID namespace 的隔离效果。修改上文的代码,加入 PID namespace 的标识位,并把程序命名为 pid.c。

//[...]

int child_pid = clone(child_main, child_stack+STACK_SIZE,

CLONE_NEWPID | CLONE_NEWIPC | CLONE_NEWUTS

| SIGCHLD, NULL);

//[...]

编译运行可以看到如下结果。

root@local:~# gcc -Wall pid.c -o pid.o && ./pid.o

程序开始:

在子进程中!

root@NewNamespace:~# echo $$

1 <<-- 注意此处看到 shell 的 PID 变成了 1

root@NewNamespace:~# exit

exit

已退出

打印 $$ 可以看到 shell 的 PID,退出后如果再次执行可以看到效果如下。

root@local:~# echo $$

17542

已经回到了正常状态。可能有的读者在子进程的 shell 中执行了 ps aux/top 之类的命令,发现还是可以看到所有父进程的 PID,那是因为我们还没有对文件系统进行隔离,ps/top 之类的命令调用的是真实系统下的 /proc 文件内容,看到的自然是所有的进程。

此外,与其他的 namespace 不同的是,为了实现一个稳定安全的容器,PID namespace 还需要进行一些额外的工作才能确保其中的进程运行顺利。

当我们新建一个 PID namespace 时,默认启动的进程 PID 为 1。我们知道,在传统的 UNIX 系统中,PID 为 1 的进程是 init,地位非常特殊。他作为所有进程的父进程,维护一张进程表,不断检查进程的状态,一旦有某个子进程因为程序错误成为了“孤儿”进程,init 就会负责回收资源并结束这个子进程。所以在你要实现的容器中,启动的第一个进程也需要实现类似 init 的功能,维护所有后续启动进程的运行状态。

看到这里,可能读者已经明白了内核设计的良苦用心。PID namespace 维护这样一个树状结构,非常有利于系统的资源监控与回收。Docker 启动时,第一个进程也是这样,实现了进程监控和资源回收,它就是 dockerinit。

PID namespace 中的 init 进程如此特殊,自然内核也为他赋予了特权——信号屏蔽。如果 init 中没有写处理某个信号的代码逻辑,那么与 init 在同一个 PID namespace 下的进程(即使有超级权限)发送给它的该信号都会被屏蔽。这个功能的主要作用是防止 init 进程被误杀。

那么其父节点 PID namespace 中的进程发送同样的信号会被忽略吗?父节点中的进程发送的信号,如果不是 SIGKILL(销毁进程)或 SIGSTOP(暂停进程)也会被忽略。但如果发送 SIGKILL 或 SIGSTOP,子节点的 init 会强制执行(无法通过代码捕捉进行特殊处理),也就是说父节点中的进程有权终止子节点中的进程。

一旦 init 进程被销毁,同一 PID namespace 中的其他进程也会随之接收到 SIGKILL 信号而被销毁。理论上,该 PID namespace 自然也就不复存在了。但是如果 /proc/[pid]/ns/pid 处于被挂载或者打开状态,namespace 就会被保留下来。然而,保留下来的 namespace 无法通过 setns() 或者 fork() 创建进程,所以实际上并没有什么作用。

我们常说,Docker 一旦启动就有进程在运行,不存在不包含任何进程的 Docker,也就是这个道理。

前文中已经提到,如果你在新的 PID namespace 中使用 ps 命令查看,看到的还是所有的进程,因为与 PID 直接相关的 /proc 文件系统(procfs)没有挂载到与原 /proc 不同的位置。所以如果你只想看到 PID namespace 本身应该看到的进程,需要重新挂载 /proc,命令如下。

root@NewNamespace:~# mount -t proc proc /proc

root@NewNamespace:~# ps a

PID TTY STAT TIME COMMAND

1 pts/1 S 0:00 /bin/bash

12 pts/1 R+ 0:00 ps a

可以看到实际的 PID namespace 就只有两个进程在运行。

注意:因为此时我们没有进行 mount namespace 的隔离,所以这一步操作实际上已经影响了 root namespace 的文件系统,当你退出新建的 PID namespace 以后再执行 ps a 就会发现出错,再次执行 mount -t proc proc /proc 可以修复错误。

在开篇我们就讲到了 unshare() 和 setns() 这两个 API,而这两个 API 在 PID namespace 中使用时,也有一些特别之处需要注意。

unshare() 允许用户在原有进程中建立 namespace 进行隔离。但是创建了 PID namespace 后,原先 unshare() 调用者进程并不进入新的 PID namespace,接下来创建的子进程才会进入新的 namespace,这个子进程也就随之成为新 namespace 中的 init 进程。

类似的,调用 setns() 创建新 PID namespace 时,调用者进程也不进入新的 PID namespace,而是随后创建的子进程进入。

为什么创建其他 namespace 时 unshare() 和 setns() 会直接进入新的 namespace 而唯独 PID namespace 不是如此呢?因为调用 getpid() 函数得到的 PID 是根据调用者所在的 PID namespace 而决定返回哪个 PID,进入新的 PID namespace 会导致 PID 产生变化。而对用户态的程序和库函数来说,他们都认为进程的 PID 是一个常量,PID 的变化会引起这些进程奔溃。

换句话说,一旦程序进程创建以后,那么它的 PID namespace 的关系就确定下来了,进程不会变更他们对应的 PID namespace。

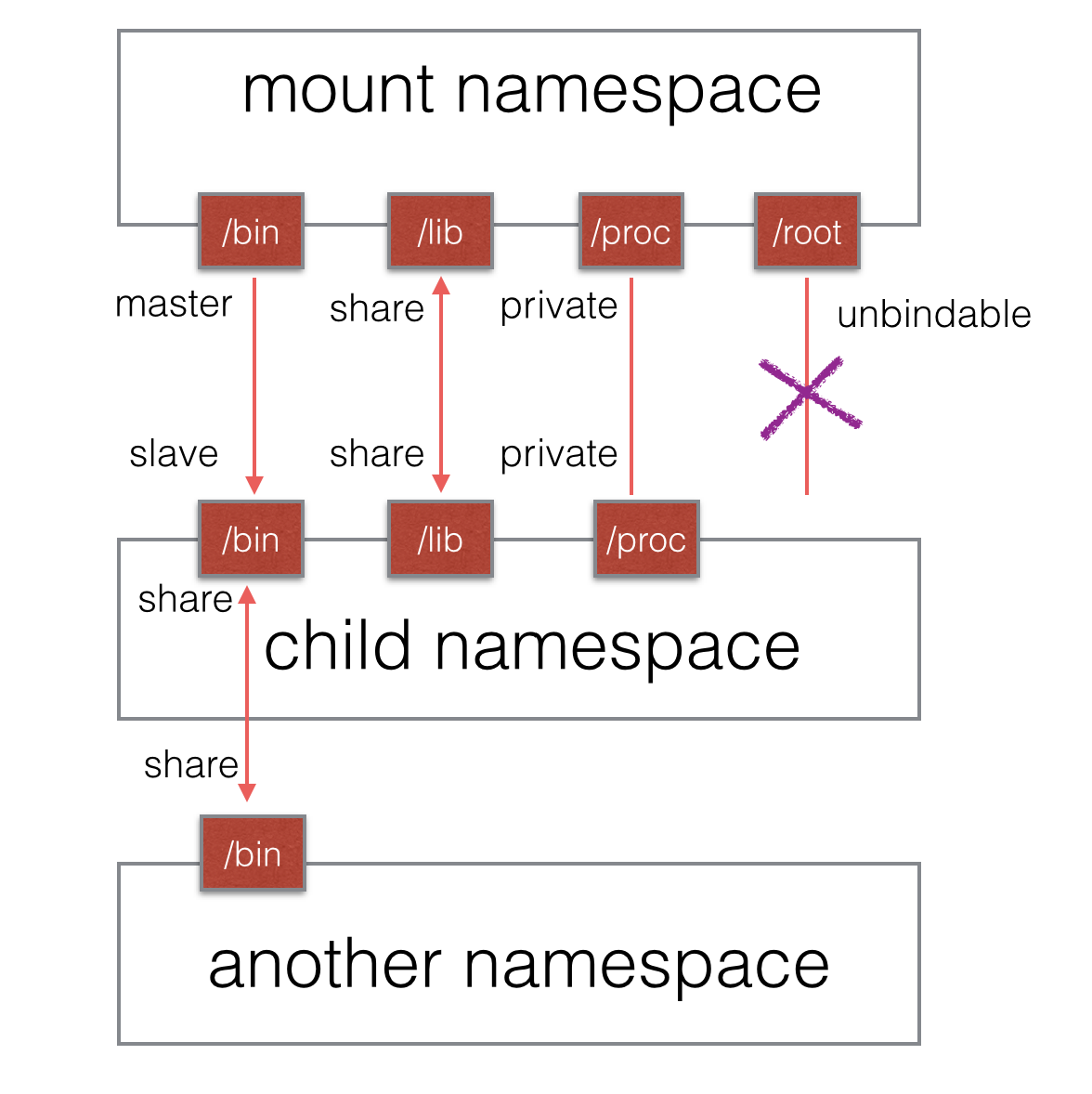

Mount namespace 通过隔离文件系统挂载点对隔离文件系统提供支持,它是历史上第一个 Linux namespace,所以它的标识位比较特殊,就是 CLONE_NEWNS。隔离后,不同 mount namespace 中的文件结构发生变化也互不影响。你可以通过 /proc/[pid]/mounts 查看到所有挂载在当前 namespace 中的文件系统,还可以通过 /proc/[pid]/mountstats 看到 mount namespace 中文件设备的统计信息,包括挂载文件的名字、文件系统类型、挂载位置等等。

进程在创建 mount namespace 时,会把当前的文件结构复制给新的 namespace。新 namespace 中的所有 mount 操作都只影响自身的文件系统,而对外界不会产生任何影响。这样做非常严格地实现了隔离,但是某些情况可能并不适用。比如父节点 namespace 中的进程挂载了一张 CD-ROM,这时子节点 namespace 拷贝的目录结构就无法自动挂载上这张 CD-ROM,因为这种操作会影响到父节点的文件系统。

2006 年引入的挂载传播(mount propagation)解决了这个问题,挂载传播定义了挂载对象(mount object)之间的关系,系统用这些关系决定任何挂载对象中的挂载事件如何传播到其他挂载对象(参考自: http://www.ibm.com/developerworks/library/l-mount-namespaces/ )。所谓传播事件,是指由一个挂载对象的状态变化导致的其它挂载对象的挂载与解除挂载动作的事件。

- 共享关系(share relationship)。如果两个挂载对象具有共享关系,那么一个挂载对象中的挂载事件会传播到另一个挂载对象,反之亦然。

- 从属关系(slave relationship)。如果两个挂载对象形成从属关系,那么一个挂载对象中的挂载事件会传播到另一个挂载对象,但是反过来不行;在这种关系中,从属对象是事件的接收者。

一个挂载状态可能为如下的其中一种:

- 共享挂载(shared)

- 从属挂载(slave)

- 共享 / 从属挂载(shared and slave)

- 私有挂载(private)

- 不可绑定挂载(unbindable)

传播事件的挂载对象称为共享挂载(shared mount);接收传播事件的挂载对象称为从属挂载(slave mount)。既不传播也不接收传播事件的挂载对象称为私有挂载(private mount)。另一种特殊的挂载对象称为不可绑定的挂载(unbindable mount),它们与私有挂载相似,但是不允许执行绑定挂载,即创建 mount namespace 时这块文件对象不可被复制。

图 1 mount 各类挂载状态示意图

共享挂载的应用场景非常明显,就是为了文件数据的共享所必须存在的一种挂载方式;从属挂载更大的意义在于某些“只读”场景;私有挂载其实就是纯粹的隔离,作为一个独立的个体而存在;不可绑定挂载则有助于防止没有必要的文件拷贝,如某个用户数据目录,当根目录被递归式的复制时,用户目录无论从隐私还是实际用途考虑都需要有一个不可被复制的选项。

默认情况下,所有挂载都是私有的。设置为共享挂载的命令如下。

mount --make-shared <mount-object>

从共享挂载克隆的挂载对象也是共享的挂载;它们相互传播挂载事件。

设置为从属挂载的命令如下。

mount --make-slave <shared-mount-object>

从从属挂载克隆的挂载对象也是从属的挂载,它也从属于原来的从属挂载的主挂载对象。

将一个从属挂载对象设置为共享 / 从属挂载,可以执行如下命令或者将其移动到一个共享挂载对象下。

mount --make-shared <slave-mount-object>

如果你想把修改过的挂载对象重新标记为私有的,可以执行如下命令。

mount --make-private <mount-object>

通过执行以下命令,可以将挂载对象标记为不可绑定的。

mount --make-unbindable <mount-object>

这些设置都可以递归式地应用到所有子目录中,如果读者感兴趣可以搜索到相关的命令。

在代码中实现 mount namespace 隔离与其他 namespace 类似,加上 CLONE_NEWNS 标识位即可。让我们再次修改代码,并且另存为 mount.c 进行编译运行。

//[...]

int child_pid = clone(child_main, child_stack+STACK_SIZE,

CLONE_NEWNS | CLONE_NEWPID | CLONE_NEWIPC

| CLONE_NEWUTS | SIGCHLD, NULL);

//[...]

执行的效果就如同 PID namespace 一节中“挂载 proc 文件系统”的执行结果,区别就是退出 mount namespace 以后,root namespace 的文件系统不会被破坏,此处就不再演示了。

通过上节,我们了解了 PID namespace,当我们兴致勃勃地在新建的 namespace 中启动一个“Apache”进程时,却出现了“80 端口已被占用”的错误,原来主机上已经运行了一个“Apache”进程。怎么办?这就需要用到 network namespace 技术进行网络隔离啦。

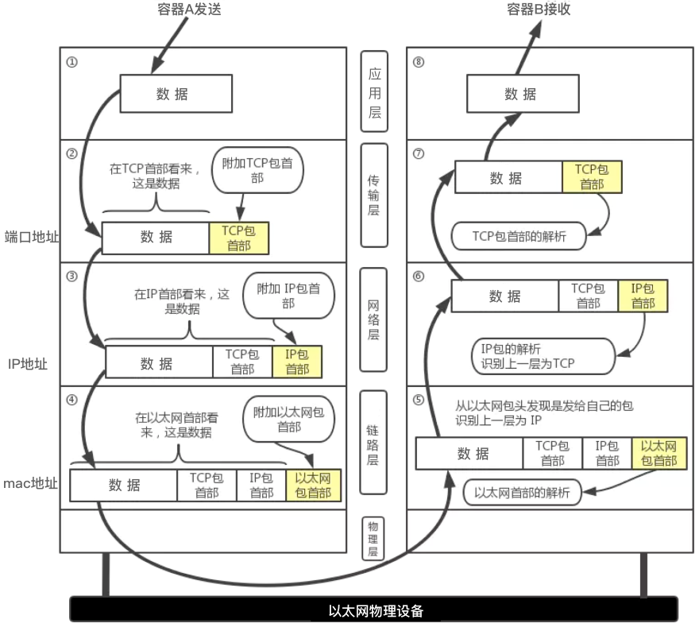

Network namespace 主要提供了关于网络资源的隔离,包括网络设备、IPv4 和 IPv6 协议栈、IP 路由表、防火墙、/proc/net 目录、/sys/class/net 目录、端口(socket)等等。一个物理的网络设备最多存在在一个 network namespace 中,你可以通过创建 veth pair(虚拟网络设备对:有两端,类似管道,如果数据从一端传入另一端也能接收到,反之亦然)在不同的 network namespace 间创建通道,以此达到通信的目的。

一般情况下,物理网络设备都分配在最初的 root namespace(表示系统默认的 namespace,在 PID namespace 中已经提及)中。但是如果你有多块物理网卡,也可以把其中一块或多块分配给新创建的 network namespace。需要注意的是,当新创建的 network namespace 被释放时(所有内部的进程都终止并且 namespace 文件没有被挂载或打开),在这个 namespace 中的物理网卡会返回到 root namespace 而非创建该进程的父进程所在的 network namespace。

当我们说到 network namespace 时,其实我们指的未必是真正的网络隔离,而是把网络独立出来,给外部用户一种透明的感觉,仿佛跟另外一个网络实体在进行通信。为了达到这个目的,容器的经典做法就是创建一个 veth pair,一端放置在新的 namespace 中,通常命名为 eth0,一端放在原先的 namespace 中连接物理网络设备,再通过网桥把别的设备连接进来或者进行路由转发,以此网络实现通信的目的。